Arweave와 IPFS의 데이터 중복성 비교

이 글에서는 Arweave와 IPFS의 이중화 메커니즘과 어떤 옵션이 데이터에 더 안전한지 살펴봅니다.

JinseFinance

JinseFinance

컴퓨팅 네트워크, 에이전트 플랫폼, 소비자 애플리케이션 등 여러 업종에서 AI와 Web3가 서로의 강점을 어떻게 활용할 수 있는지 논의해봤습니다. 서로를 보완할 수 있습니다. 데이터 리소스 분야에 초점을 맞출 때 웹 이머전스는 데이터 액세스, 공유, 활용에 새로운 가능성을 제시하는 프로젝트를 의미합니다.

기존 데이터 제공업체는 AI 및 기타 데이터 중심 산업에서 실시간으로 검증 가능한 고품질 데이터에 대한 수요를 충족하는 데 어려움을 겪고 있습니다.

Web3 솔루션은 데이터 생태계를 재편하기 위해 노력하고 있습니다. MPC, 영지식 증명, TLS Notary와 같은 기술 분산 스토리지와 엣지 컴퓨팅은 실시간 데이터 처리를 위한 유연성과 효율성을 높여주며, MPC, 영지식 증명, TLS 공증인은 데이터가 여러 소스로 이동할 때 진본성과 개인 정보 보호를 보장합니다.

새로운 분산형 데이터 네트워크 인프라는 OpenLayer(모듈식 실제 데이터 계층), Grass(모듈식 실제 데이터 네트워크), Grid(모듈식 실제 데이터 네트워크) 같은 여러 상징적인 프로젝트를 탄생시켰습니다. 데이터 레이어), Grass(사용자의 유휴 대역폭과 탈중앙화를 활용하는 크롤러 노드 네트워크), Vana(사용자 데이터 주권을 위한 레이어 1 네트워크)를 통해 다양한 기술 경로를 가진 AI 학습 및 애플리케이션 등의 영역에서 새로운 가능성을 열어가고 있습니다.

크라우드소싱 용량, 신뢰 없는 추상화 계층, 토큰 기반 인센티브를 통해 탈중앙화된 데이터 인프라는 웹2.0 하이퍼스케일보다 더 개인적이고 안전하며 효율적이고 경제적인 웹2 하이퍼스케일러보다 더 안전하고 효율적이며 경제적인 솔루션을 제공하고, 사용자가 자신의 데이터와 관련 리소스를 제어하여 보다 개방적이고 안전하며 상호 운용 가능한 디지털 생태계를 구축할 수 있도록 지원합니다.

1. 왼쪽;">데이터는 산업 전반에 걸쳐 혁신과 의사결정의 핵심 동력이 되었으며, UBS는 2020년과 2030년 사이에 전 세계 데이터 양이 660ZB로 10배 이상 증가하고 2025년에는 전 세계가 1인당 하루에 463EB(엑사바이트, 1EB = 10억 GB)의 데이터를 생성할 것으로 전망하고 있습니다. 서비스형 데이터(DaaS) 시장은 빠른 속도로 확장되고 있으며, Grand View Research의 보고서에 따르면 2023년 전 세계 DaaS 시장은 143억 6,000만 달러에 달하고 2030년까지 28.1%의 연평균 성장률로 성장하여 궁극적으로 768억 달러에 달할 것으로 예상됩니다. 이러한 고성장의 배경에는 여러 산업 부문에서 신뢰할 수 있는 고품질의 실시간 데이터에 대한 수요가 있습니다.

AI 모델 학습은 패턴 인식과 매개변수 조정을 위해 많은 양의 데이터 입력에 의존합니다. 또한 모델의 성능과 일반화 기능을 테스트하기 위해 학습 후 데이터 세트가 필요합니다. 또한, 예측 가능한 미래의 새로운 인텔리전스 애플리케이션 형태인 AI 에이전트는 정확한 의사 결정과 작업 실행을 보장하기 위해 신뢰할 수 있는 실시간 데이터 소스가 필요합니다.

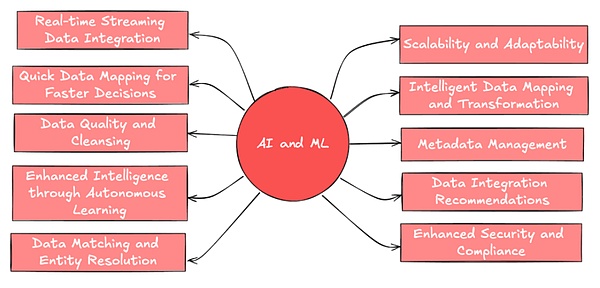

( 출처: Leewayhertz)

비즈니스 분석의 필요성 또한 다양하고 광범위해지고 있으며, 조직의 혁신을 추진하는 핵심 도구로 자리 잡고 있습니다. 예를 들어, 소셜 미디어 플랫폼과 시장 조사 회사는 전략을 수립하고 트렌드에 대한 인사이트를 얻고 여러 소셜 플랫폼의 여러 데이터 세트를 통합하여 보다 포괄적인 그림을 구축하기 위해 신뢰할 수 있는 사용자 행동 데이터가 필요합니다.

웹3 생태계 역시 새로운 금융 상품을 지원하기 위해 신뢰할 수 있고 확실한 데이터가 필요합니다. 점점 더 많은 새로운 유형의 자산이 통과함에 따라 혁신적인 상품 개발과 리스크 관리를 지원하고 검증 가능한 실시간 데이터를 기반으로 스마트 컨트랙트를 실행할 수 있는 유연하고 신뢰할 수 있는 데이터 인터페이스가 필요합니다.

위 사례 외에도 연구, 사물 인터넷(IoT) 등이 있습니다. 새로운 사용 사례를 통해 산업 전반에 걸쳐 다양한 실제 데이터에 대한 수요가 급증하고 있으며, 레거시 시스템은 빠르게 증가하는 데이터 양과 변화하는 요구 사항을 처리하는 데 어려움을 겪을 수 있습니다.

2. 기존 데이터 에코시스템의 한계와 문제점

일반적인 데이터 생태계에는 데이터 수집, 저장, 처리, 분석 및 적용이 포함됩니다. 중앙 집중식 모델은 데이터가 중앙에서 수집 및 저장되고, 핵심 엔터프라이즈 IT 팀이 관리 및 유지 관리하며, 엄격한 액세스 제어를 받는 것이 특징입니다.

예를 들어, Google의 데이터 에코시스템은 검색 엔진, Gmail, Android 운영 체제 등의 여러 데이터 소스를 포함합니다. 이러한 플랫폼에서 사용자 데이터를 수집하여 전 세계에 분산된 데이터 센터에 저장한 다음 알고리즘을 사용하여 처리 및 분석하여 다양한 제품 및 서비스의 개발과 최적화를 지원합니다.

예를 들어 금융 시장에서는 데이터 및 인프라 회사인 LSEG(구 Refinitiv)가 글로벌 거래소, 은행 및 기타 주요 금융 기관의 실시간 및 과거 데이터와 자체 Reuters News 네트워크를 사용하여 시장 관련 뉴스를 수집합니다. 뉴스를 수집하고, 독점 알고리즘과 모델을 사용하여 분석 데이터와 위험 평가를 추가 상품으로 생성합니다.

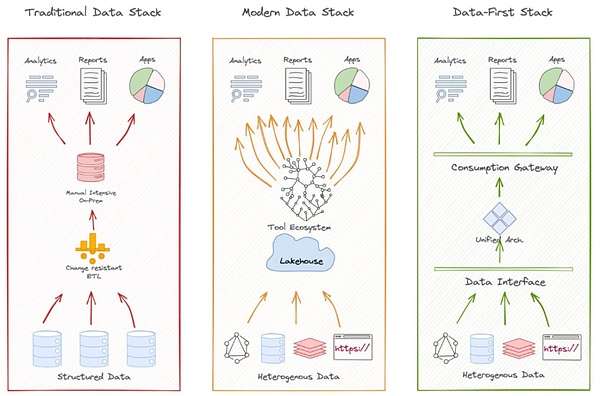

( 출처: kdnuggets.com)

전통적인 데이터 아키텍처는 전문 서비스에는 효과적이었지만 중앙 집중식 모델의 한계가 점점 더 분명해지고 있습니다. 특히, 기존의 데이터 생태계는 새로운 데이터 소스의 적용 범위, 투명성 및 사용자 개인정보 보호 측면에서 문제에 직면하고 있습니다. 다음은 몇 가지 예입니다.

불충분한 데이터 범위: 기존 데이터 서비스 제공업체는 소셜 미디어 정서, IoT 디바이스 데이터 등과 같은 새로운 데이터 소스를 신속하게 수집하고 분석하는 데 어려움을 겪고 있습니다. 중앙 집중식 시스템은 수많은 소규모 또는 비주류 소스의 '롱테일' 데이터를 효율적으로 수집하고 통합하는 데 어려움을 겪고 있습니다.

데이터 접근성의 제약: 독점으로 인해 접근성이 제한됩니다. 많은 기존 제공업체가 API/클라우드 서비스를 통해 데이터의 일부를 개방하고 있지만, 높은 액세스 비용과 복잡한 인증 절차로 인해 데이터 통합이 여전히 어렵습니다.

온체인 개발자가 신뢰할 수 있는 오프체인 데이터에 빠르게 접근하기 어렵고, 소수의 대기업이 고품질 데이터를 독점하며, 접근 비용이 높습니다.

데이터 투명성 및 신뢰성 문제: 많은 중앙화된 데이터 제공자들은 데이터 수집 및 처리 방식에 대한 투명성이 부족하고 효과적인 대규모 데이터의 진위 여부와 무결성을 검증할 수 있는 효과적인 메커니즘이 부족합니다. 대규모 실시간 데이터의 검증은 여전히 복잡한 문제로 남아 있으며, 중앙 집중화의 특성상 데이터 변조나 조작의 위험이 증가합니다.

개인정보 보호 및 데이터 소유권: 대형 기술 기업은 대규모로 사용자 데이터를 상업화합니다. 개인 데이터의 생성자인 사용자는 그 대가로 정당한 가치를 얻기가 어렵습니다. 사용자는 자신의 데이터가 어떻게 수집, 처리, 사용되는지 알 방법이 없는 경우가 많으며, 데이터가 어디에 어떻게 사용되는지 결정하기 어렵습니다. 또한 과도한 데이터 수집과 사용은 심각한 개인정보 보호 위험을 초래합니다.

예를 들어, Facebook의 Cambridge Analytica 사태는 기존의 데이터 제공업체들이 데이터 사용 투명성과 개인정보 보호에 얼마나 큰 공백이 있는지를 드러냈습니다.

데이터 사일로: 또한, 다양한 출처와 형식의 실시간 데이터를 신속하게 통합하기 어렵기 때문에 종합적인 분석의 가능성에 영향을 미칩니다. 많은 데이터가 조직 내에 잠겨 있는 경우가 많아 산업과 조직 전반에서 데이터 공유와 혁신이 제한되며, 데이터 사일로 효과는 도메인 간 데이터 통합과 분석을 방해합니다.

예를 들어, 소비자 업계의 경우 브랜드는 이커머스 플랫폼, 오프라인 매장, 소셜 미디어, 시장 조사에서 얻은 데이터를 통합해야 하는데, 플랫폼 형식이 일관되지 않거나 분리되어 있어 통합이 어려울 수 있습니다. 또 다른 예로 Uber와 Lyft와 같은 공유 모빌리티 회사는 사용자로부터 교통량, 라이더의 요구사항, 지리적 위치 등 대량의 실시간 데이터를 수집하지만, 경쟁으로 인해 이러한 데이터를 통합을 위해 제시하고 공유할 수 없습니다.

그 외에도 비용 효율성과 유연성 문제도 있습니다. 기존 데이터 공급업체들은 이러한 문제를 적극적으로 해결하고 있지만, Web3 기술의 등장은 이러한 문제를 해결할 수 있는 새로운 아이디어와 가능성을 제공합니다.

2014년 이래로 2014년 IPFS(InterPlanetary File System)와 같은 탈중앙화 스토리지 솔루션이 출시된 이후, 업계에서는 기존 데이터 생태계의 한계를 해결하기 위한 새로운 프로젝트들이 잇따라 등장하고 있습니다. 분산형 데이터 솔루션은 데이터 생성, 저장, 교환, 처리 및 분석, 인증 및 보안, 개인정보 보호 및 소유권 등 데이터 라이프사이클의 모든 단계를 아우르는 다층적이고 상호 연결된 생태계를 형성하는 것을 목격했습니다.

데이터 스토리지: Filecoin과 Arweave의 빠른 성장은 분산형 스토리지(DCS)가 스토리지의 패러다임 변화로 부상하고 있다는 증거입니다. DCS 솔루션은 분산 아키텍처를 통해 단일 장애 지점의 위험을 줄이는 동시에 비용 효율성이 높은 참여자들을 끌어모으고 있습니다. DCS의 스토리지 용량은 일련의 확장 사용 사례와 함께 폭발적으로 증가했습니다(예: 2024년 Filecoin 네트워크의 총 스토리지 용량은 22엑사바이트에 도달했습니다).

프로세싱 및 분석: 플루언스와 같은 탈중앙화 데이터 컴퓨팅 플랫폼은 엣지 컴퓨팅(Edge Computing) 기술을 통해 데이터 처리의 실시간성과 효율성을 개선하며, 이는 특히 사물인터넷(IoT) 및 AI 추론과 같이 실시간 요구 사항이 높은 애플리케이션 시나리오에 적합합니다.Web3 프로젝트는 연합 학습, 차등 개인정보 보호, 신뢰할 수 있는 실행 환경 및 완전 동형 암호화를 활용하여 계산 수준에서 다음과 같은 기능을 제공합니다. 유연한 개인정보 보호와 절충안을 제공합니다.

데이터 마켓플레이스/교환 플랫폼: 데이터의 가치와 유통의 정량화를 촉진하기 위해 Ocean Protocol은 토큰화 및 DEX 메커니즘을 통해 효율적이고 효과적인 데이터 마켓플레이스와 교환 플랫폼을 구축합니다. 예를 들어, 오션 프로토콜은 DEX 메커니즘을 통해 효율적이고 개방적인 데이터 교환 채널을 만들어 전통적인 제조 회사(메르세데스 벤츠의 모기업인 다임러)가 공급망 관리에서 데이터 공유를 촉진하기 위해 데이터 교환 시장 개발에 협력할 수 있도록 지원합니다. 반면 Streamr는 IoT 및 실시간 분석 시나리오를 위한 라이선스 없는 구독 기반 데이터 스트리밍 네트워크를 구축하여 운송 및 물류 프로젝트(예: 핀란드 스마트 시티 프로젝트)에서 큰 잠재력을 보여주었습니다.

데이터의 교환과 활용이 증가하면서 데이터 진본성, 신뢰성, 개인정보 보호는 무시할 수 없는 핵심 이슈가 되었습니다. 이에 따라 Web3 생태계는 데이터 검증 및 개인 정보 보호로 혁신을 확장하여 일련의 획기적인 솔루션을 내놓았습니다.

많은 웹3 기술 및 네이티브 프로젝트는 다음과 같이 노력하고 있습니다. 데이터 진위성 및 개인 데이터 보호 문제를 해결하기 위해 노력하고 있습니다. ZK 외에도 MPC와 같은 기술 개발이 널리 사용되고 있으며, 특히 새로운 인증 방법으로 TLS Notary(전송 계층 보안 프로토콜 공증인)가 주목받고 있습니다.

TLS Notary 소개

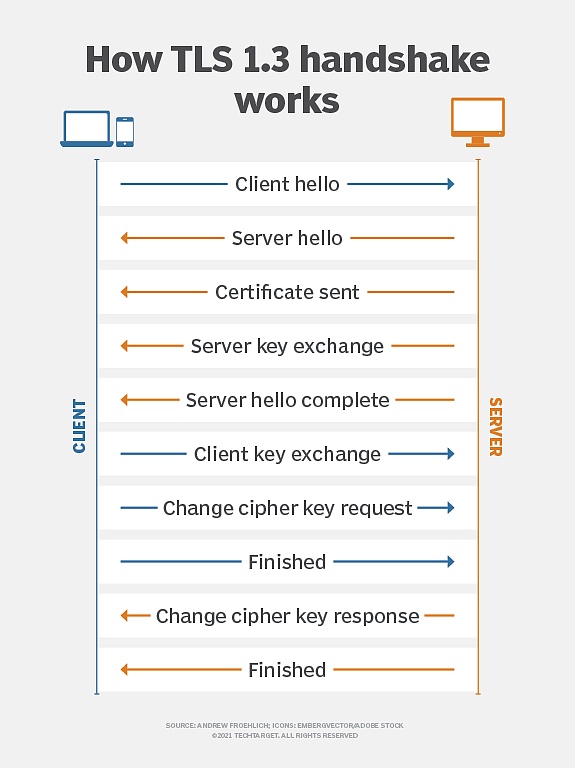

TLS(전송 계층 보안)는 널리 사용되고 있는 네트워크 통신을 위한 암호화 프로토콜로, 클라이언트와 서버 간 데이터 전송의 보안, 무결성 및 기밀성을 보장하기 위해 설계되었습니다. 최신 웹 통신을 위한 일반적인 암호화 표준이며 HTTPS, 이메일, 인스턴트 메시징 등 다양한 시나리오에서 사용됩니다.

( TLS 암호화 원칙, 출처: TechTarget)

10년 전 탄생 당시 TLS Notary의 원래 목표는 클라이언트(Prover), 서버 또는 서버 외부에 제3자 "공증인"을 도입하여 서비스 품질을 개선하는 것이었습니다. "공증인"은 TLS 세션의 진위 여부를 확인합니다.

키 분할 기술을 사용하여 TLS 세션의 마스터 키는 클라이언트와 공증인이 두 부분으로 나누어 보유합니다. 이 설계를 통해 공증인은 신뢰할 수 있는 제3자로서 인증 프로세스에 참여할 수 있지만 실제 통신 내용에는 액세스할 수 없습니다. 이 공증 메커니즘은 중간자 공격을 탐지하고, 위조 인증서를 방지하며, 통신 데이터가 전송 중에 변조되지 않았는지 확인하고, 신뢰할 수 있는 제3자가 통신의 개인정보를 보호하면서 통신의 적법성을 확인할 수 있도록 설계되었습니다.

따라서 TLS Notary는 안전한 데이터 유효성 검사를 제공하고 인증의 필요성과 개인정보 보호 간의 균형을 효과적으로 유지합니다.

2022년, 이더넷 재단의 프라이버시 및 확장 탐색(PSE) 연구소에서 TLS Notary 프로젝트를 재구축했습니다. 새로운 버전의 TLS Notary 프로토콜은 Rust로 처음부터 다시 작성되었으며, MPC와 같은 고급 암호화 프로토콜과 사용자가 데이터의 내용을 공개하지 않고 제3자에게 서버로부터 받은 데이터의 진위를 증명할 수 있는 새로운 프로토콜 기능을 통합했습니다. 기존 TLS Notary의 핵심 인증 기능은 유지하면서 개인정보 보호 기능을 대폭 개선하여 현재와 미래의 데이터 개인정보 보호 요구사항에 더욱 적합하게 만들었습니다.

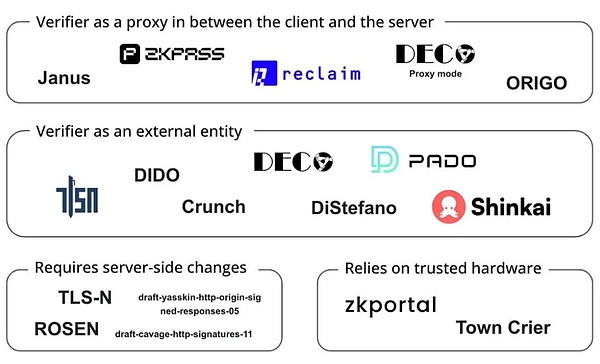

TLS Notary 기술은 최근 몇 년 동안 계속 발전해왔습니다. 개인 정보 보호 및 인증을 더욱 강화하는 여러 변형을 만들어 내기 위해 그 기반을 바탕으로 계속 발전해 왔습니다.

ZkTLS Notary Technology

< strong>zkTLS: 사용자가 민감한 정보를 노출하지 않고도 웹 데이터의 암호화된 증명을 생성할 수 있도록 ZKP 기술을 통합한 개인정보 보호 강화 버전의 TLS Notary입니다. 매우 높은 수준의 개인 정보 보호가 필요한 통신 시나리오에 적합합니다.

3P-TLS(3자 TLS): 클라이언트, 서버, 감사자에 대한 3자 접근 방식을 도입하여 통신 내용을 공개하지 않고 감사를 허용합니다. 통신 내용을 공개하지 않고 감사할 수 있는 3자 접근 방식을 도입하여 감사자가 통신의 보안을 확인할 수 있도록 합니다. 이 프로토콜은 규정 준수 검토 또는 금융 거래 감사와 같이 투명성이 필요하지만 개인정보 보호도 필요한 시나리오에 유용합니다.

웹3 프로젝트는 이러한 암호화 기술을 사용하여 데이터 인증 및 개인정보 보호를 강화하고, 데이터 독점을 깨고, 데이터 사일로 및 신뢰할 수 있는 전송을 해결하며, 사용자가 소셜 미디어 계정 소유권, 금융 대출 구매 내역, 은행 신용 기록 및 직업 이력 등을 개인정보 침해 없이 증명할 수 있도록 합니다. 다음과 같은 기록, 은행 신용 기록, 직업적 배경, 학력 등

Reclaim 프로토콜은 zkTLS 기술을 사용하여 HTTPS 트래픽의 영지식 증명을 생성함으로써 사용자가 민감한 정보를 노출하지 않고도 외부 사이트에서 활동, 평판 및 신원 데이터를 안전하게 가져올 수 있도록 합니다.

zkPass는 3P-TLS 기술을 결합하여 사용자가 실제 개인 데이터를 공개하지 않고 검증할 수 있도록 하며 KYC 및 신용 서비스 등의 시나리오에서 널리 사용되며, HTTPS 네트워크입니다.

오파시티 네트워크는 zkTLS를 기반으로 사용자가 플랫폼(예: Uber, Spotify, Netflix 등) 전반에서 자신의 활동을 안전하게 증명할 수 있게 해줍니다. 해당 플랫폼의 API에 직접 액세스하지 않고도 크로스 플랫폼 활동을 증명할 수 있습니다.

(작업 중인 프로젝트 on TLS 오라클, 출처: Bastian Wetzel)

데이터 생태계 사슬의 중요한 연결 고리인 Web3 데이터 유효성 검사는 유망한 애플리케이션이며, 그 생태적 붐은 보다 개방적이고 역동적이며 사용자 중심의 디지털 경제로 이끌고 있습니다. 그러나 진위 확인 기술의 개발은 차세대 데이터 인프라 구축의 시작에 불과합니다.

일부 프로젝트는 다음과 같은 기술을 결합합니다. 위의 데이터 검증 기술은 데이터 생태계의 업스트림, 즉 데이터 추적성, 분산 데이터 수집 및 신뢰할 수 있는 전송에 대한 보다 심층적인 탐구와 결합됩니다. 다음 논의에서는 차세대 데이터 인프라 구축의 고유한 잠재력을 보여주는 몇 가지 대표적인 프로젝트인 OpenLayer, Grass, Vana에 초점을 맞추고 있습니다.

a16z Crypto의 2024년 봄 암호화폐 스타트업 액셀러레이터 프로그램 중 하나인 OpenLayer는 웹2와 웹3 기업의 요구를 모두 충족하는 최초의 모듈형 실제 데이터 레이어로서 데이터의 수집, 검증 및 변환을 조율하는 혁신적인 모듈형 솔루션을 제공하는 데 전념하고 있습니다.OpenLayer는 지오메트리를 포함한 여러 기업을 유치했습니다. 벤처스, 롱해시 벤처스, 그리고 기타 주요 펀드와 엔젤 투자자들을 포함한 여러 기업들로부터 투자를 유치했습니다.

기존 데이터 계층은 신뢰할 수 있는 인증 메커니즘의 부족, 중앙화된 아키텍처에 의존해 접근성이 제한되고 시스템 간 데이터의 상호운용성과 이동성이 부족하며 데이터의 가치를 배분하는 공정한 메커니즘이 부족하다는 여러 가지 문제를 안고 있습니다.

보다 가시적인 문제는 오늘날 AI 학습 데이터가 점점 더 부족해지고 있다는 점입니다. 퍼블릭 인터넷에서 많은 사이트가 크롤러 방지 제한을 통해 AI 기업이 대규모로 데이터를 크롤링하지 못하도록 막고 있습니다.

개인 소유 데이터의 경우 상황은 더욱 복잡해지며, 민감한 특성상 많은 가치 있는 데이터가 프라이버시가 보호되는 방식으로 저장되어 있고 효과적인 인센티브가 부족합니다. 이러한 상황에서 사용자는 개인 데이터를 제공함으로써 직접적인 혜택을 안전하게 얻을 수 없기 때문에 민감한 데이터를 공유하기를 꺼리게 됩니다.

오픈레이어는 이러한 문제를 해결하기 위해 데이터 검증 기술을 결합하여 데이터 수집을 조율하는 탈중앙화 + 경제적 인센티브와 함께 모듈식 인증 데이터 레이어를 구축합니다, 탈중앙화 + 경제적 인센티브 방식으로 데이터 수집, 검증 및 변환 프로세스를 조율하여 웹2.0 및 웹3.0 기업에게 보다 안전하고 효율적이며 유연한 데이터 인프라를 제공하는 인증 및 변환 프로세스.

OpenLayer는 데이터 수집, 신뢰성 검증 및 변환 프로세스를 간소화하는 모듈형 플랫폼을 제공합니다.

a) OpenNodes

a) OpenNodes

오픈노드는 탈중앙화된 데이터 수집을 담당하는 오픈레이어 생태계의 핵심 구성 요소로, 사용자 모바일 앱, 브라우저 확장 프로그램 및 기타 채널을 통해 데이터를 수집하며, 다양한 사업자/노드가 하드웨어 사양에 따라 가장 적합한 작업을 수행하여 수익을 최적화할 수 있습니다.

OpenNodes는 다양한 유형의 작업 요구를 충족하기 위해 세 가지 주요 데이터 유형을 지원합니다:

공개적으로 사용 가능한 인터넷 데이터(예: 재무 데이터, 날씨 데이터, 스포츠 데이터, 소셜 미디어 스트림)

개인 사용자 데이터(예: 넷플릭스 시청 기록, 아마존 주문 기록 등)

보안 소스로부터 자체 보고된 데이터(예: 독점적인 소유자 서명으로 확인된 데이터 또는 소유자 서명 또는 신뢰할 수 있는 특정 하드웨어로 확인된 데이터).

개발자는 새로운 데이터 유형을 쉽게 추가하고, 새로운 데이터 소스, 요구사항, 데이터 검색 방법을 지정할 수 있으며, 사용자는 보상을 받는 대신 비식별화된 데이터를 제공하도록 선택할 수 있습니다. 이러한 설계 덕분에 새로운 데이터 요구사항을 수용하기 위해 시스템을 지속적으로 확장할 수 있으며, 데이터 소스의 다양성을 통해 다양한 애플리케이션 시나리오에 대한 포괄적인 데이터 지원을 제공하고 데이터 제공의 장벽을 낮출 수 있는 OpenLayer가 가능합니다.

b) OpenValidators

OpenValidators는 다음을 담당합니다. 수집 후 데이터 유효성 검사, 사용자가 제공한 데이터가 데이터 소스와 정확히 일치하는지 데이터 소비자가 확인할 수 있도록 합니다. 제공되는 모든 유효성 검사 방법은 암호화 방식으로 증명할 수 있으며, 유효성 검사 결과는 사후에 확인할 수 있습니다. 여러 제공업체에서 동일한 유형의 증명을 사용할 수 있습니다. 개발자는 자신의 필요에 가장 적합한 유효성 검사 제공업체를 선택할 수 있습니다.

초기 사용 사례, 특히 인터넷 API의 공개 또는 비공개 데이터의 경우, OpenLayer는 모든 웹 애플리케이션에서 데이터를 내보내고 프라이버시를 손상시키지 않고 진위를 증명하는 유효성 검사 솔루션으로 TLSNotary를 사용합니다. 프라이버시 침해 없이 진본성을 증명합니다.

검증 시스템은 모듈식 설계 덕분에 TLSNotary에 국한되지 않고 다음과 같은 다양한 유형의 데이터와 검증 요구 사항을 수용하기 위해 다른 검증 방법을 쉽게 플러그인할 수 있습니다.

검증된 TLS 연결: 전송 중인 데이터의 무결성과 신뢰성을 보장하기 위해 신뢰 실행 환경(TEE)을 사용하여 인증된 TLS 연결을 설정합니다. 인증된 TLS 연결: TEE(신뢰할 수 있는 실행 환경)를 사용하여 인증된 TLS 연결을 설정하여 전송 중인 데이터의 무결성과 신뢰성을 보장합니다.

보안 인클레이브: 하드웨어 수준의 보안 인클레이브(예: Intel SGX)를 사용하여 민감한 데이터를 처리하고 검증함으로써 더 높은 수준의 데이터 보호 기능을 제공합니다.

ZK 증명 생성기: ZKP와 통합하여 원본 데이터를 노출하지 않고 데이터 속성 또는 계산의 유효성을 검사할 수 있습니다.

c) OpenConnect

c) OpenConnect: OpenConnect는 오픈커넥트 애플리케이션입니다. OpenConnect는 사용성을 위해 데이터를 변환하고, 다양한 소스의 데이터를 처리하며, 다양한 애플리케이션의 요구 사항을 충족하기 위해 서로 다른 시스템 간의 상호 운용성을 보장하는 OpenLayer 에코시스템의 핵심 모듈입니다. 예를 들어:

스마트 컨트랙트에 직접 사용하기 위해 데이터를 온체인 Oracle 형식으로 변환합니다.

비정형 원시 데이터를 정형 데이터로 변환하여 AI 학습 및 기타 목적을 위한 전처리를 수행합니다.

사용자의 개인 계정에서 가져온 데이터의 경우, OpenConnect는 개인정보 보호를 위한 데이터 탈감작 기능과 데이터 공유 중 보안을 강화하고 데이터 유출 및 오용을 줄이기 위한 구성 요소를 제공합니다. AI 및 블록체인과 같은 애플리케이션에 대한 실시간 데이터 수요를 충족하기 위해 OpenConnect는 효율적인 실시간 데이터 변환을 지원합니다.

오픈레이어 AVS 운영자는 아이젠레이어와의 통합을 통해 데이터 요청 작업을 수신하고 데이터를 크롤링하여 검증한 후 그 결과를 다시 시스템에 보고하고, 아이젠레이어를 통해 자산을 담보 또는 대체하여 경제적 담보를 제공할 수 있습니다. 아이겐 레이어는 해당 행위에 대한 경제적 담보를 제공하기 위해 자산을 담보하거나 재담보합니다. 악의적인 행위가 확인되면 담보 자산이 몰수될 수 있는 위험에 직면하게 됩니다. 오픈레이어는 아이겐레이어 메인넷의 첫 번째 AVS(액티브 검증 서비스) 중 하나로, 50개 이상의 운영자와 40억 달러의 리플리지를 유치했습니다.

전반적으로 OpenLayer는 유용성과 효율성을 희생하지 않고 사용 가능한 데이터의 범위와 다양성을 확장하는 동시에 암호화와 경제적 인센티브를 통해 데이터 진위성과 무결성을 보장하는 탈중앙화된 데이터 레이어를 구축합니다. 이 기술은 오프체인 정보에 액세스하려는 웹 3.0 디앱, 실제 입력으로 학습하고 추론해야 하는 AI 모델, 기존 신원 및 평판을 기반으로 사용자를 세분화하고 타겟팅하려는 기업 등 다양한 실제 사용 사례를 보유하고 있습니다. 또한 사용자는 자신의 개인 데이터를 가치 있게 평가할 수 있습니다.

Grass는 와이어드 네트워크에서 개발한 플래그십 프로젝트입니다. 탈중앙화된 웹 크롤러와 AI 학습 데이터 플랫폼을 만들기 위해 개발된 Wynd Network의 주력 프로젝트입니다. 2023년 말, 그라스 프로젝트는 폴리체인 캐피탈과 트라이브 캐피탈이 주도하는 350만 달러 규모의 시드 라운드를 마감했습니다. 그 직후인 2024년 9월, 이 프로젝트는 폴리체인, 델파이, 래티스, 브레반 하워드 등 주요 투자 기관의 참여로 HackVC가 주도하는 또 다른 시리즈 A 펀딩 라운드를 진행했습니다.

AI 학습에는 새로운 데이터 노출이 필요하며 한 가지 해결책은 여러 IP를 사용하여 데이터 액세스에서 벗어나 AI에 데이터를 공급하는 것입니다. Grass는 여기서 출발하여 분산 크롤러 노드를 만들기 시작했습니다. 분산형 물리적 인프라에서 사용자의 유휴 대역폭을 사용해 AI 학습을 위한 검증 가능한 데이터 세트를 수집하고 제공하는 전용 네트워크입니다. 이 노드는 사용자의 인터넷 연결을 통해 웹 요청을 라우팅하여 공개적으로 이용 가능한 웹사이트에 액세스하고 구조화된 데이터 세트를 컴파일합니다. 초기 데이터 정리 및 포맷을 위해 엣지 컴퓨팅 기술을 사용하여 데이터 품질을 개선합니다.

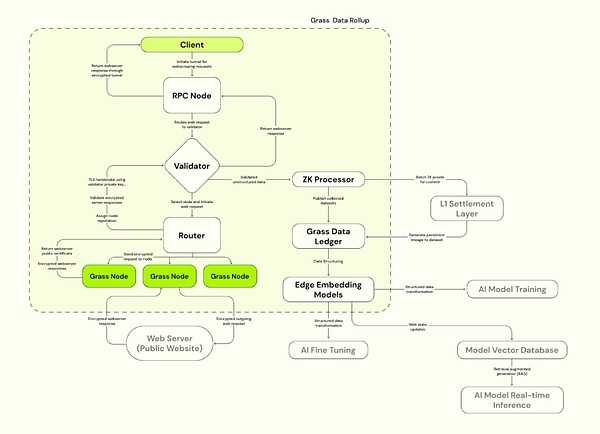

Grass는 처리 효율성을 개선하기 위해 솔라나를 기반으로 구축된 솔라나 레이어 2 데이터 롤업 아키텍처를 사용하고, 검증자를 사용해 노드로부터 웹 트랜잭션을 수신, 검증, 일괄 처리하여 데이터 진위 여부를 보장하는 ZK 인증서를 생성합니다. 데이터의 신뢰성을 보장합니다. 검증된 데이터는 원장(L2)에 저장되고 해당 L1 온체인 증명에 연결됩니다.

a) Grass 노드

오픈노드와 유사하게, 최고 경영진 사용자는 Grass 앱 또는 브라우저 확장 프로그램을 설치하고 실행하여 유휴 대역폭을 활용하여 웹 크롤러 작업을 수행하고, 노드는 사용자의 인터넷 연결을 통해 웹 요청을 라우팅하여 공개 웹사이트에 액세스합니다. 공개 웹사이트에 액세스하고 엣지 컴퓨팅 기술을 사용하여 초기 데이터 정리 및 포맷을 위해 구조화된 데이터 세트를 컴파일합니다. 사용자는 기여한 대역폭과 데이터의 양에 따라 GRASS 토큰으로 보상을 받습니다.

b) 라우터

그래스 노드와 검증자를 연결하여 노드 네트워크를 관리하고 대역폭을 중계합니다. 라우터는 라우터를 통해 릴레이된 총 인증 대역폭에 비례하여 보상을 받고 운영하도록 인센티브를 받습니다.

c) 검증자

라우터로부터 웹 트랜잭션을 수신, 검증 및 일괄 처리하여 제로 퍼센트(ZP)와 제로 퍼센티지(ZP)를 생성합니다. Grass는 현재 중앙화된 인증자를 사용하고 있으며, 향후 인증자 위원회로 전환할 계획입니다.

d) ZK 프로세서

인증자로부터 모든 노드의 세션 데이터를 생성하는 증명을 받습니다. 노드 세션 데이터, 모든 웹 요청에 대한 유효성 증명을 일괄 처리하여 레이어 1(Solana)에 제출합니다.

e) Grass 데이터 원장(Grass L2)

전체 데이터셋을 저장하고 해당 L1 체인(솔라나)을 증명에 연결합니다.

f) 엣지 임베딩 모델

비정형 웹 데이터를 AI 학습에 사용할 수 있도록 변환하는 역할을 담당합니다. 구조화된 모델.

Source: Grass

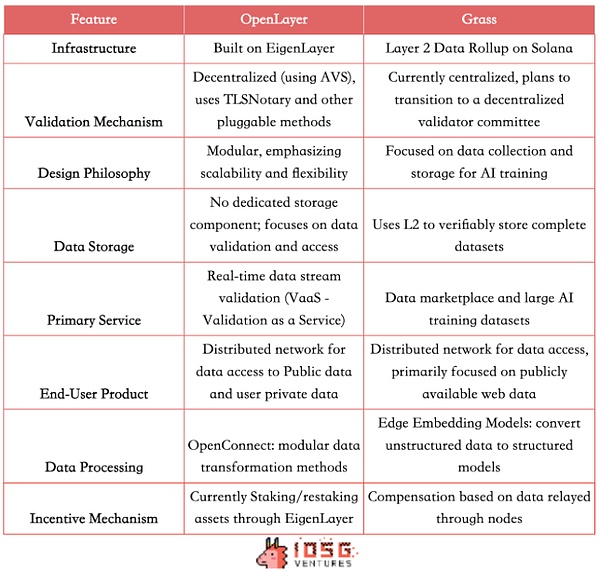

기술 아키텍처의 차이

Grass는 현재 중앙화된 중앙 데이터 계층을 사용하는 Solana의 레이어 2 데이터 롤업 아키텍처를 사용합니다. 솔라나의 롤업 아키텍처는 현재 단일 유효성 검사기를 사용하는 중앙 집중식 유효성 검사 메커니즘을 사용합니다. 최초의 AVS 중 하나인 오픈레이어는 경제적 인센티브와 몰수 메커니즘을 사용하여 <강력>분산화된 검증 메커니즘을 달성하기 위해 아이겐레이어에 구축되었습니다. 또한 데이터 검증 서비스의 확장성과 유연성을 강조하는 모듈식 설계를 채택하고 있습니다.

제품 차이점

두 제품 모두 사용자가 데이터 노드에 노드할 수 있는 유사한 To C 제품을 제공합니다. 가치 실현을 위한 노드를 제공합니다. To B 사용 사례의 경우, Grass는 흥미로운 데이터 마켓플레이스 모델을 제공하며 L2를 사용해 완전한 데이터를 검증 가능하게 저장하여 AI 회사에 구조화되고 검증 가능한 고품질의 학습 세트를 제공합니다. 반면 OpenLayer는 임시 전용 데이터 스토리지 구성 요소는 없지만, 보다 광범위한 실시간 데이터 스트림 검증 서비스(Vaas)를 제공하여 AI에 데이터를 제공하는 것 외에도 RWA/DeFi/예측 시장 프로젝트에 가격을 공급하는 오라클 역할, 실시간 소셜 데이터 제공 등 빠른 대응이 필요한 시나리오에 적합합니다.

그 결과, 현재 Grass의 목표 고객층은 주로 AI 기업과 데이터 과학자를 대상으로 하며, 대규모의 구조화된 학습 데이터 세트를 제공하고, 대량의 네트워크 데이터 세트가 필요한 연구 기관과 기업에도 서비스를 제공하고 있습니다; Openlayer는 일시적으로 오프체인 개발자들을 위한 오프체인 온체인 개발자를 위한 데이터 소스, 실시간 검증 가능한 데이터 스트림이 필요한 AI 기업, 경쟁사 사용 내역 확인과 같은 혁신적인 사용자 확보 전략을 지원하는 웹2.0 기업 등을 대상으로 합니다.

향후 경쟁 가능성

하지만 업계 동향을 고려할 때 향후 두 프로젝트의 기능이 융합될 가능성은 충분히 있습니다. Grass는 곧 실시간 구조화된 데이터도 제공할 예정입니다. 모듈형 플랫폼인 OpenLayer는 향후 자체 데이터 원장을 갖춘 데이터 세트 관리로 확장할 가능성이 높기 때문에 두 프로젝트의 경쟁 영역이 점차 겹칠 수 있습니다.

그리고 두 프로젝트 모두 데이터 라벨링이라는 중요한 측면을 추가하는 것을 고려할 수 있는데, Grass는 220만 개가 넘는 대규모 노드 네트워크 덕분에 더 빠르게 발전할 수 있을 것으로 보입니다. 이러한 이점을 통해 Grass는 라벨링된 대량의 데이터를 사용해 AI 모델을 최적화하는 강화 학습 기반 휴먼 피드백(RLHF) 서비스를 제공할 수 있는 잠재력을 갖게 되었습니다.

그러나 데이터 검증 및 실시간 처리에 대한 전문성과 개인 데이터에 중점을 둔 OpenLayer가 데이터 품질과 신뢰성에서 우위를 유지할 가능성이 높습니다. 또한, 오픈레이어는 아이겐레이어의 AVS 중 하나로서 탈중앙화된 검증 메커니즘을 더 깊이 있게 다룰 수 있을 것입니다.

두 프로젝트는 일부 영역에서 경쟁할 수도 있지만, 고유한 강점과 기술 경로를 통해 데이터 생태계에서 서로 다른 틈새를 차지할 수도 있습니다.

( 출처: IOSG, David)

4.3 VAVA

사용자 중심의 데이터 풀 네트워크인 Vana는 AI 및 관련 애플리케이션을 위한 고품질 데이터를 제공하기 위해 최선을 다하고 있습니다. Vana는 2024년 9월에 코인베이스 벤처스가 주도하는 500만 달러 규모의 펀딩 라운드를 마감했으며, Paradigm이 주도하는 1800만 달러 규모의 시리즈 A에 이어 Polychain, Casey Caruso 등 유명 투자자들이 참여한 가운데 5백만 달러 규모의 펀딩을 마감했습니다. 케이시 카루소 등

2018년 MIT의 연구 프로젝트로 처음 시작된 Vana는 개인 사용자 데이터를 위해 특별히 설계된 레이어 1 블록체인을 목표로 합니다. 데이터 소유권과 가치 분배의 혁신을 통해 사용자는 자신의 데이터로 학습된 AI 모델을 통해 수익을 창출할 수 있으며, Vana의 핵심은 신뢰할 수 없고 개인적이며 귀속 가능한 데이터 유동성 풀과 혁신적인 공헌 증명 메커니즘을 통해 블록체인을 생성하는 기능에 있습니다. 개인 데이터의 흐름과 가치화를 가능하게 하는 기여 증명 메커니즘:

4.3.1. 데이터 유동성 풀

Vana는 데이터 유동성 풀(DLP)이라는 독특한 개념을 도입했습니다. 각 DLP는 Vana 네트워크의 핵심 구성 요소로서 특정 유형의 데이터 자산을 집계하는 별도의 피어투피어(P2P) 네트워크입니다. 사용자는 자신의 개인 데이터(예: 쇼핑 내역, 검색 습관, 소셜 미디어 활동 등)를 특정 DLP에 업로드하고 특정 제3자가 이 데이터를 사용할 수 있도록 승인할지 여부를 유연하게 선택할 수 있습니다. 데이터는 이러한 유동성 풀을 통해 통합 및 관리되며, 이 데이터는 비식별 처리되어 사용자 개인정보를 보호하는 동시에 AI 모델 학습이나 시장 조사와 같은 상업적 애플리케이션에 참여할 수 있도록 합니다.

사용자는 DLP에 데이터를 제출하고 데이터 풀에 대한 사용자의 기여를 나타낼 뿐만 아니라 사용자에게 DLP에 대한 거버넌스 권한과 향후 수익을 분배할 권리를 부여하는 해당 DLP 토큰(각 DLP에 특정)으로 보상을 받습니다. 사용자는 데이터를 공유할 뿐만 아니라 데이터에 대한 후속 호출을 통해 지속적인 수익을 얻을 수 있습니다(시각적 추적 기능 제공). 기존의 일회성 데이터 판매와 달리 Vana는 데이터가 지속적으로 경제 사이클에 참여할 수 있도록 합니다.

4.3.2. 기여 증명 메커니즘

Vana의 핵심 혁신 중 하나는 기여 증명 메커니즘입니다. Vana의 핵심 혁신 중 하나는 기여 증명 메커니즘입니다. 이는 데이터 품질을 보장하는 Vana의 핵심 메커니즘으로, 각 DLP의 특성에 따라 고유한 기여 증명 기능을 맞춤화하여 데이터의 진위와 무결성을 검증하고 AI 모델의 성능 향상에 대한 데이터의 기여도를 평가할 수 있습니다. 이 메커니즘은 사용자의 데이터 기여도를 정량화하고 문서화하여 사용자에게 보상을 제공합니다. 암호화폐의 작업 증명과 유사하게 기여 증명은 사용자가 기여한 데이터의 품질, 양, 사용 빈도에 따라 수익을 분배합니다. 이는 기여자가 기여에 대한 보상을 받을 수 있도록 하는 스마트 계약을 통해 자동화됩니다.

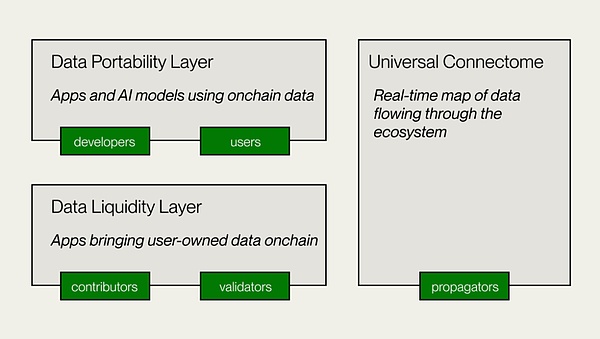

데이터 유동성 레이어

이 레이어는 Vana의 핵심 레이어로서 데이터의 기여, 검증 및 기록을 담당하며, 데이터를 체인에 양도 가능한 디지털 자산으로 도입합니다.DLP 생성자는 데이터 기여의 목적, 검증 방법 및 기여 매개변수를 설정하는 DLP 스마트 컨트랙트를 배포합니다. 데이터 기여자와 관리자는 검증을 위해 데이터를 제출하고, 기여 증명(PoC) 모듈은 데이터 검증과 가치 평가를 수행하여 매개변수에 따라 거버넌스 권한과 보상을 부여합니다.

데이터 이동성 레이어

데이터 기여자와 개발자를 위한 오픈 데이터 플랫폼이자 Vana의 애플리케이션 계층으로, 데이터 이동성 계층은 데이터 기여자와 개발자가 DLP에 축적된 데이터 이동성을 사용하여 애플리케이션을 구축할 수 있는 협업 공간을 제공합니다. 애플리케이션 구축을 위한 데이터 이동성. 사용자 소유 모델의 분산 학습, AI Dapp 개발을 위한 인프라를 제공합니다.

Universal Connectome

지분 증명 합의를 사용하여 Vana 생태계 전반의 실시간 데이터 거래를 기록하는 탈중앙화된 원장 및 실시간 데이터 흐름 그래프입니다. DLP 토큰의 효율적인 전송을 보장하고 애플리케이션을 위한 DLP 간 데이터 액세스를 제공합니다. EVM과 호환되어 다른 네트워크, 프로토콜, 디파이 앱과의 상호운용성을 지원합니다.

( 출처: Vana)

Vana는 사용자 데이터의 이동성과 가치에 초점을 맞춘 다른 경로를 제공하며, 이 분산형 데이터 교환 모델은 AI 학습 및 데이터 시장 시나리오에 적합할 뿐만 아니라 웹3 생태계에서 사용자 데이터의 플랫폼 간 상호운용성 및 권한 부여를 위한 기회도 제공합니다. 이 탈중앙화된 데이터 교환 모델은 AI 트레이닝 및 데이터 마켓플레이스와 같은 시나리오에 적용될 뿐만 아니라 Web3 생태계에서 사용자 데이터의 크로스 플랫폼 상호운용성 및 권한 부여를 위한 새로운 솔루션을 제공하여 궁극적으로 사용자가 자신의 데이터와 해당 데이터에서 생성되는 스마트 제품을 소유하고 관리하는 개방형 인터넷 생태계를 조성합니다.

5.분산형 데이터 네트워크의 가치 제안

데이터 과학자 클라이브 험비는 2006년에 데이터는 새로운 시대의 석유라고 말했습니다. 지난 20년 동안 우리는 '정제' 기술의 급속한 발전을 목격했습니다. 빅데이터 분석과 머신러닝과 같은 기술은 이전과는 전혀 다른 방식으로 데이터의 가치를 실현했습니다. IDC에 따르면 2025년까지 전 세계 데이터 유니버스는 163ZB로 증가할 것이며, 이 중 대부분은 개인 사용자로부터 생성될 것이며, IoT, 웨어러블, AI, 개인 맞춤형 서비스 등 신흥 기술의 인기로 인해 향후 상업적으로 이용 가능한 데이터의 상당량도 개인으로부터 생성될 것으로 예상됩니다.

웹3 데이터 솔루션은 분산된 노드 네트워크를 통해 기존 설비의 한계를 극복하여 보다 광범위하고 효율적인 데이터 수집이 가능하며, 특정 데이터에 대한 실시간 접근 및 신뢰성 검증의 효율성을 향상시킵니다. 이 과정에서 Web3 기술은 데이터의 신뢰성과 무결성을 보장하고 사용자의 개인정보를 효과적으로 보호하여 보다 공정한 데이터 활용 모델을 구현합니다. 이러한 탈중앙화된 데이터 아키텍처는 데이터 액세스의 민주화를 촉진합니다.

오픈레이어와 Grass의 사용자 노드 모델이나 Vana의 사용자 개인 데이터 수익화는 특정 데이터 수집의 효율성을 개선할 뿐만 아니라 일반 사용자가 데이터 경제의 배당금을 공유함으로써 사용자와 개발자가 윈윈하는 모델을 만들어냅니다.

Vana 모델은 사용자가 자신의 데이터와 데이터와 관련된 리소스를 제어해야 한다는 생각에 기반을 두고 있습니다.

웹3 데이터 솔루션은 토큰 이코노미를 통해 인센티브 모델을 재설계하여 보다 공정한 데이터 가치 분배 메커니즘을 만들었습니다. 이를 통해 사용자, 하드웨어 리소스 및 자본의 대규모 투입을 유도하여 전체 데이터 네트워크의 운영을 조정하고 최적화합니다.

또한 기존 데이터 솔루션보다 모듈형 및 확장성이 뛰어납니다. 예를 들어 Openlayer의 모듈식 설계는 향후 기술 반복 및 생태적 확장을 위한 유연성을 제공합니다. AI 모델 학습을 위한 데이터 액세스를 최적화하는 기술적 기능 덕분에 더욱 풍부하고 다양한 데이터 세트를 제공합니다. 데이터 생성, 저장, 검증, 교환, 분석에 이르기까지 웹3 기반 솔루션은 고유한 기술적 장점을 통해 기존 시설의 많은 단점을 해결하는 동시에 사용자가 개인 데이터를 현금화할 수 있도록 지원하여 데이터 경제 모델에 근본적인 변화를 일으킵니다. 기술이 발전하고 애플리케이션 시나리오가 확장됨에 따라 분산형 데이터 계층은 다른 Web3 데이터 솔루션과 함께 차세대 핵심 인프라가 되어 다양한 데이터 기반 산업을 지원할 것으로 예상됩니다.

이 글에서는 Arweave와 IPFS의 이중화 메커니즘과 어떤 옵션이 데이터에 더 안전한지 살펴봅니다.

JinseFinance

JinseFinance이 백서에서는 Arweave와 IPFS가 파일을 저장, 유지, 액세스하는 방법과 이것이 디지털 자산의 안정성과 지속성에 어떤 영향을 미치는지 살펴봅니다.

JinseFinance

JinseFinance이 백서는 현재 이더리움 생태계의 리스테이크, AVS 및 유동성 리스테이크 회로의 핵심 이슈를 살펴보고 위험 및 보상 평가를 위한 유사한 프레임워크를 예측적으로 제시합니다.

JinseFinance

JinseFinanceArweave의 핵심 메커니즘에서 매우 중요한 개념이자 구성 요소 중 하나는 저장 기금 인다우먼트입니다.

JinseFinance

JinseFinance오늘 가족 휴가 사진 앨범을 네트워크 스토리지에 업로드하면 200년이 지난 후에도 후손들이 그 앨범을 볼 수 있다고 상상해 보세요.

JinseFinance

JinseFinance현재 시장의 주류 탈중앙화 스토리지로는 Arweave, Filecoin, Storj가 있으며, 각각 고유한 기능과 디자인 컨셉을 가지고 있습니다.

JinseFinance

JinseFinance이 기술은 온라인 환경과의 안전한 분리를 유지하면서 자산의 수작업 처리와 관련된 위험을 완화하는 것을 목표로 합니다.

Alex

Alex소프트웨어 및 IT 컨설팅 분야의 강자인 IBM은 Hyper Protect 오프라인 서명 오케스트레이터를 출시하여 웹3.0 분야에서 새로운 바람을 일으키고 있습니다.

Aaron

Aaron마이클 세일러의 BTC 주소를 추적하는 세이로트래커의 데이터에 따르면, 그의 포트폴리오는 7,102,706,533.19달러로 33.37% 상승하며 사상 최고치를 기록했습니다.

Brian

Brian분산형 스토리지는 Web3의 필수 인프라입니다. 그러나 이 단계에서 스토리지 규모든 성능이든 분산형 스토리지는 아직 초기 단계이며 중앙 집중식 스토리지와는 거리가 멀다. 이 기사에서는 Storj, Filecoin, Arweave, Stratos Network, Ceramic과 같은 몇 가지 대표적인 스토리지 프로젝트를 선택하고 성능, 비용, 시장 위치, 시장 가치 및 기타 정보를 요약 및 비교하고 기술 원칙을 분석하고 생태학적 진행을 요약합니다.

链向资讯

链向资讯