暗号投資家、Chrome拡張機能のセキュリティ欠陥で80万ドルの損失に直面

調査の結果、このトレーダーは、グーグル・クローム・ブラウザのセキュリティ侵害が、特に特定の暗号ウォレット拡張機能を狙ったキーロガーによって実際に引き起こされたことを確認した。

Kikyo

Kikyo

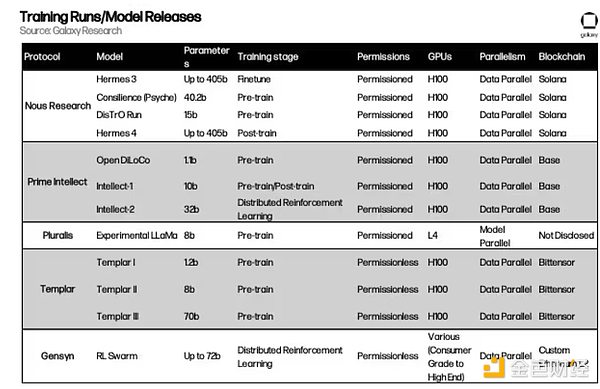

By Lucas Tcheyan, Arjun Yenamandra, Source:Galaxy Research, Compiled by Golden Finance

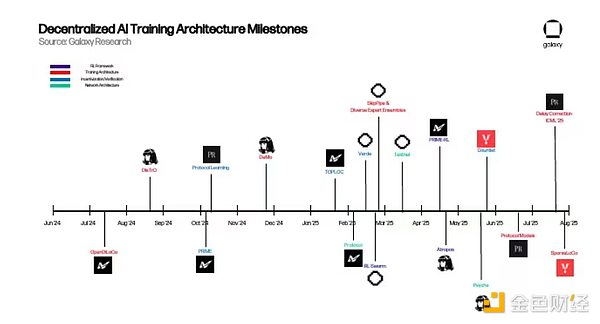

昨年、ギャラクシー・リサーチは暗号通貨と人工知能の交差点に関する最初の記事を発表した。この記事では、暗号通貨のトラストレス・パーミッションレスなインフラが、どのようにAIイノベーションの基盤となり得るかを探った。これには、グラフィックス・プロセッサ(GPU)の不足に対応して登場した処理能力(またはコンピュート)の分散型市場の出現、検証可能なオンチェーン推論のためのゼロ知識機械学習(zkML)の早期利用、複雑なやり取りを簡素化し、暗号通貨をネイティブな交換媒体として使用する自律型AIエージェントの可能性などが含まれる。

当時、これらの取り組みの多くはまだ初期段階にあり、中央集権的なソリューションに対する実用的な利点を示唆する説得力のある概念実証がいくつかあるだけで、AIの展望を再構築するほどにはまだスケールアップしていませんでした。しかしその後1年で、分散型AIは実装に向けて有意義な進歩を遂げた。この勢いを捉え、最も有望な進歩を明らかにするために、Galaxy Researchは、暗号+AIフロンティアの特定の垂直を掘り下げる一連の記事を来年にリリースする予定です。

「Decentralised Training」に最初に掲載されたこの記事では、世界規模でベースモデルのパーミッションレス・トレーニングを可能にするために取り組んでいるプロジェクトに焦点を当てています。これらのプロジェクトの動機は2つある。実用的な観点からは、世界中の膨大な量の未使用GPUをモデルのトレーニングに使用することで、世界中のAIエンジニアに通常では手の届かないトレーニングプロセスを提供し、オープンソースのAI開発を実現できることを認識している。概念的な観点から言えば、これらのチームの動機は、中央集権的なAI研究所が、現代における最も重要な技術革命のひとつを厳しく管理していること、そして、オープンな代替手段を作ることが急務であることにある。

より広義には、暗号空間にとって、分散型トレーニングとそれに続く基礎モデルのトレーニングを可能にすることは、ライセンスを必要とせず、すべてのレイヤーでアクセス可能な完全なオンチェーンAIスタックを構築する上で重要なステップです。zkMLプロバイダーは、モデルの出力を検証し、プライバシーを保護するために使用することができます。aIエージェントは、モデル、データソース、およびプロトコルを組み合わせて、より高次のアプリケーションを構築するための構成可能なビルディングブロックとして使用することができます。

本レポートでは、分散型AIプロトコルの基本的なアーキテクチャ、それらが解決を目指す技術的問題、分散型トレーニングの将来について探求します。暗号通貨とAIの根本的な前提は、1年前と変わっていない。暗号通貨はAIのために、パーミッションレス、トラストレス、コンポーザブルな価値移転決済レイヤーを提供する。現在の課題は、分散型アプローチが中央集権型アプローチと比較して真の利点を提供できることを証明することである。

分散型トレーニングの最新の進歩を掘り下げる前に、大規模言語モデル(Large Language Models: LLM)とその基礎となるアーキテクチャについて基本的な理解を持つことが必要です。これは、読者がこれらのプロジェクトがどのように機能し、彼らが解決しようとしている主な問題を理解するのに役立ちます。

ChatGPTのような大規模言語モデル(LLM)は、Transformerと呼ばれるアーキテクチャによって動いています。2017年にGoogleが発表した論文「Attention is all you need(注意力がすべて)」で初めて提案されたTransformerは、AI開発における最も重要なイノベーションのひとつだ。一言で言えば、Transformerはデータ(トークンと呼ばれる)を抽出し、それらのトークン間の関係を学習するために様々なメカニズムを適用する。

トークン間の関係は、重みを使ってモデル化される。重みは、モデルを構成する数百万から数兆のノブと考えることができ、シーケンスの次の単語を一貫して予測できるようになるまで、常に調整されます。学習が完了すると、モデルは基本的に人間の言語の背後にあるパターンと意味を捉える。

Transformerのトレーニングの主な構成要素には以下が含まれます:

Forward Passing:「フォワード・パッシング」では、「フォワード・パッシング」を行います。学習プロセスの最初のステップでは、Transformerはより大きなデータセットからトークンのバッチを入力される。これらの入力に基づいて、モデルは次のトークンが何になるべきかを予測しようとする。トレーニングの開始時に、モデルの重みはランダム化される。

損失の計算:次に、順伝播予測は損失スコアを計算するために使用されます。言い換えれば、順伝播中にモデルによって生成された予測値が、そのモデルを訓練するために使用されたより大きなデータセット内の実際のマーカーと比較してどうなのか、ということです。トレーニング中、モデルの精度を向上させるために、この損失スコアを減らすことが目標となります。

Backpropagation: 損失スコアは、各重みの勾配を計算するために使われます。これらの勾配は、次の順伝播の前に、損失を減らすために重みを調整する方法をモデルに伝えます。

Optimizer update:Optimizerアルゴリズムは、これらの勾配を読み取り、損失を減らすために各重みを調整します。

繰り返し:すべてのデータが消費され、モデルがコンバージェンスに到達し始めるまで繰り返します言い換えれば、それ以上の最適化によって損失の大幅な削減やパフォーマンスの向上が得られなくなったときです。

モデルをトレーニングする完全なプロセスは、事前トレーニングと事後トレーニングの2つの別々のステップで構成されます。.上記のステップは、プレトレーニングプロセスの核となるコンポーネントです。上記のステップは、プレトレーニングプロセスの中心的な構成要素です。プレトレーニングプロセスが完了すると、ベースモデルと呼ばれる、事前にトレーニングされたベースモデルが生成されます。

しかし、プレトレーニングの後、モデルは通常さらに改善する必要があり、これをポストトレーニングと呼びます。ポストトレーニングは、精度を向上させたり、翻訳や医療診断などの特定のユースケースのためにカスタマイズするなど、さまざまな方法でベースモデルをさらに改善するために使用されます。

ポストトレーニングは、大規模言語モデル(LLM)を今日のような強力なツールにするための重要なステップです。ポストトレーニングにはいくつかの異なるアプローチがあります。

Supervised fine-tuning (SFT): SFTは上述の事前学習プロセスに非常に似ています。主な違いは、ベースモデルが、より注意深くキュレートされたデータセットやヒントと回答に基づいて学習されることで、特定の指示に従うことを学習したり、特定のドメインに焦点を当てることができます。

強化学習(RL): 新しいデータを与えてモデルを改善するのではなく、RLはモデルの出力に対して報酬を得点し、その報酬を最大化するようにモデルに重みを更新させることで機能します。最近では、推論モデル(後述)が RL を使って出力を向上させている。近年、学習前のスケーリング問題が顕在化し続けているため、学習後の推論モデルでRLを使用することで、追加のデータや大規模な計算を必要とせずにモデルの性能を大幅に向上させることができるため、大きな進歩が見られます。

具体的には、RLポストトレーニングは、分散型トレーニング(後述)で直面する障害に対処するのに理想的です。というのも、RLではほとんどの場合、モデルはフォワードパス(モデルは予測を行うが、それ自身はまだ変化していない)を使って大量の出力を生成するからである。これらのフォワード・パスは、マシン間の協調や通信を必要とせず、非同期で実行できる。また、並列化も可能です。つまり、複数のGPUで同時に実行できる独立したサブタスクに分割することができます。これは、各ロールアウトが独立して計算できるためであり、計算を追加するだけでトレーニング実行によりスループットをスケールアップできる。最適な答えが選択された後にのみ、モデルは内部の重みを更新するため、マシンを同期させる必要がある頻度を減らすことができます。

学習後のモデルを使用して出力を生成するプロセスは、推論と呼ばれます。

学習後にモデルを使用して出力を生成するプロセスは、推論と呼ばれています。法学修士(LLM)にとって、推論とは、手がかりを受け取り、それをモデルの各層に通し、最も可能性の高い次のマーカーを段階的に予測することを意味する。推論は、バックプロパゲーション(モデルの誤差に基づいて重みを調整するプロセス)や重みの更新を必要としないため、トレーニングよりもはるかに計算負荷が少ないが、最新のモデルはサイズが大きいため、リソース集約的であることに変わりはない。

一言で言えば、推論はチャットボット、コードアシスタント、翻訳ツールのようなアプリを動かすものです。この段階で、モデルは「学習」を実践に移します。

上記のトレーニングプロセスを促進することは、リソースを大量に消費し、大規模に運用するためには高度に専門化されたソフトウェアとハードウェアが必要です。OpenAIのCEOであるSam Altmanは、GPT-4のトレーニングには1億ドル以上の費用がかかったと述べ、AnthropicのCEOであるDario Amodeiは、10億ドル以上のトレーニングプロジェクトがすでに進行中であると述べた。

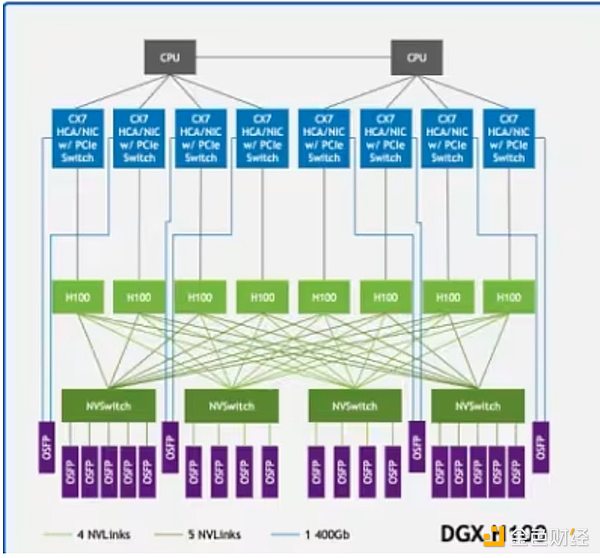

これらのコストの大部分はGPUによるもので、NVIDIAのH100やB200のような最高級GPUは1台あたり3万ドルもし、OpenAIは2025年末までに100万台以上のGPUを導入する予定だと伝えられています。しかし、GPUのパワーだけでは十分ではない。NVIDIA NVLinkのような技術は、サーバー内のGPU間の高速データ交換をサポートし、InfiniBandはサーバーのクラスタを接続して、単一の統合されたコンピューティング・ファブリックとして動作できるようにします。

DGX H100サンプル・アーキテクチャのNVLinkはシステム内のGPU(薄緑色の四角形)を接続し、InfiniBandはサーバー(緑色の線)を接続します。

DGX H100サンプル・アーキテクチャのNVLinkはシステム内のGPU(薄緑色の四角形)を接続し、InfiniBandはサーバー(緑色の線)を接続します。

その結果、基礎となるモデルのほとんどは、OpenAI、Anthropic、Meta、Google、xAIなどの中央集権的なAIラボによって開発されました。xAIなどの中央集権的なAIラボによって開発されてきた。トレーニングに必要な豊富なリソースを持っているのは、そうした大手だけだ。このことは、モデルの訓練とパフォーマンスにおいて大きなブレークスルーをもたらした一方で、主要な基本モデルの開発を少数の事業体の手に集中管理させることにもなった。さらに、スケーリングの法則が働いている可能性があり、計算やデータを追加するだけでは、事前に訓練されたモデルのインテリジェンスを増強する効果が制限されるという証拠も増えている。

この課題に対処するため、ここ数年、AIエンジニアのグループが、これらの技術的な複雑さに対処し、莫大なリソース要件を削減する試みとして、モデル学習の新しいアプローチを開発し始めています。本稿では、この取り組みを「分散型トレーニング」と呼ぶ。

ビットコインの成功は、大規模な経済ネットワークを確保するために、分散型の方法で計算と資本を調整できることを証明しています。分散型トレーニングは、許可、信頼、インセンティブの不在を含む暗号通貨の特性を活用し、中央集権型プロバイダーに匹敵する強固な基本モデルをトレーニングできる分散型ネットワークを構築することを目的としています。

分散型トレーニングでは、世界中のさまざまな場所にあるノードが、権限のないインセンティブ付きのネットワーク上で動作し、AIモデルのトレーニングに貢献します。これは分散型トレーニングとは異なり、モデルのトレーニングは地理的に異なる場所で行われるが、(ホワイトリストプロセスを通じて)ライセンスを受けた1つまたは複数のエンティティによって行われる。しかし、分散型トレーニングの実行可能性は、分散型トレーニングの上に構築されなければならない。多くの中央集権的なラボは、トレーニング・セットアップの深刻な限界を認識し、既存のセットアップと同等の結果を得るために、分散型トレーニングを実装する方法を模索し始めている。

分散型トレーニングの実現を阻む現実的な障壁がいくつかあります:

Communication overhead:通信のオーバーヘッド。strong>ノードが地理的に分散している場合、上記のような通信インフラを利用することができません。分散型トレーニングでは、標準的なネットワーク速度、大量のデータの頻繁な転送、トレーニング中のGPUの同期を考慮する必要があります。

検証:分散型トレーニングネットワークは本質的にパーミッションレスであり、誰でもコンピューティングパワーを提供できるように設計されています。そのため、貢献者が不正確な入力や悪意のある入力によってネットワークを破壊しようとしたり、システムの脆弱性を悪用して正当な仕事を貢献せずに報酬を得ようとしたりするのを防ぐために、検証メカニズムを開発する必要があります。

Compute: 規模にかかわらず、分散型ネットワークはモデルを訓練するのに十分なコンピューティングパワーを集約しなければなりません。分散型ネットワークはもともと、GPUがあれば誰でもトレーニングプロセスに参加できるように設計されているため、これはある程度分散型ネットワークの強みを発揮しますが、一方で、これらのネットワークは異種混合の計算を調整しなければならないため、複雑さももたらします。

インセンティブ/資金調達/所有権と収益化:分散型トレーニングネットワークは、ネットワークの完全性を効果的に確保し、計算プロバイダー、検証者、モデル設計者の貢献に対して報酬を与えるような、インセンティブと所有権/収益化モデルを用いて設計されなければなりません。これは、モデルが単一の企業によって構築され、収益化される集中型ラボとは対照的です。

このような制限があるにもかかわらず、多くのプロジェクトが分散型トレーニングを推進しています。彼らの目標は、少数の中央集権的な製品に依存することによる単一障害点、データのプライバシーと検閲、スケーラビリティ、AIの一貫性と偏りなど、中央集権的なトレーニングに関連するリスクに対抗することだ。より広い意味では、オープンソースのAI開発はオプションではなく、必要不可欠なものだと考えている。オープンで検証可能なインフラがなければ、イノベーションは抑制され、アクセスは一部の特権階級に制限され、社会は狭い企業のインセンティブによって形成されたAIシステムを継承することになるだろう。この観点から、分散型トレーニングは競争力のあるモデルを構築するだけでなく、専有的な利益ではなく集団的な利益を反映する、弾力性があり、透明性があり、参加型のエコシステムを構築することでもある。

以下では、いくつかの分散型トレーニングプロジェクトの根底にあるメカニズムを詳しく概観します。

背景

2022年に設立されたヌースリサーチは、オープンソースのAI研究組織です。チームは、オープンソースAIコードの限界に取り組むオープンソースAI研究者と開発者の非公式グループとして始まった。その使命は、「最高のオープンソースモデルを作成し、提供する」ことである。

チームは早い段階で、分散型トレーニングが大きな障害であると認識しました。具体的には、GPUへのアクセスやGPU間の通信を調整するツールは、主に中央集権的な大規模AI企業のために開発されたものであり、リソースに制約のある組織が有意義な開発に携わる余地はほとんどないことに気づきました。例えば、B200などのNVIDIAの最新のBlackwell GPUは、NVLinkスイッチングシステムを使用して、1秒あたり最大1.8テラバイトの速度で相互に通信することができます。これは、主流のインターネットインフラの総帯域幅に匹敵するものであり、集中化されたデータセンター規模の展開でのみ可能です。その結果、小規模なネットワークや分散型ネットワークでは、通信ポリシーを見直さない限り、大規模なAIラボのパフォーマンスを達成することは事実上不可能です。

分散型トレーニング問題に着手する前に、NousはすでにAIの分野に大きな貢献をしていました。2023年8月、NousはYaRN: Efficient Context Window Extension for Large Language Modelsを発表しました。この論文では、単純だが重要な問題に取り組んでいる。ほとんどのAIモデルは、一度に一定量のテキスト(つまり「コンテキスト・ウィンドウ」)しか記憶・処理できない。例えば、2,000語という制限で訓練されたモデルは、入力文書が長くなるとすぐに情報を忘れたり失ったりし始める。これはモデルが単語の位置を追跡する方法(本のしおりのようなもの)を適応させることで、テキストが何万語という長さであっても、情報の流れを追跡できるようにする。このアプローチにより、モデルは最大128,000トークン(マーク・トウェインの『ハックルベリー・フィンの冒険』の長さとほぼ同じ)のシーケンスを処理することができる。つまりYaRNは、AIモデルがはるかに長い文書、対話、データセットを一度に「読み」、理解することを可能にする。これはAI能力の拡張における大きな前進であり、OpenAIや中国のDeepseekなど、より広範な研究コミュニティによって採用されている。

DeMoとDisTrO

2024年3月、Nousは「Decoupled Momentum Optimization」と呼ばれる分散学習のブレークスルーを発表しました。「DeMoは、Nousの研究者であるBowen Peng氏とJeffrey Quesnelle氏、そしてDiederik P. Kingma氏(OpenAIの共同設立者)によって開発されました。DeMoは、Nousの研究者であるBowen PengとJeffrey Quesnelleが、OpenAIの共同設立者でありAdamWオプティマイザーの発明者であるDiederik P. Kingmaと共同で開発しました。これは、Nousの分散型トレーニングスタックの主要な構成要素であり、GPU間で交換されるデータ量を削減することで、分散データ並列モデルトレーニングセットアップにおける通信オーバーヘッドを削減します。データ並列トレーニングでは、各ノードはモデルの重みの完全なコピーを保持しますが、データセットは異なるノードによって処理されるチャンクに分割されます。

AdamWは、モデル学習に最もよく使用されるオプティマイザーの1つです。AdamWの主な機能は、モデル重みの過去の変化の実行平均である運動量として知られているものを滑らかにすることです。Nousリサーチは、AdamWとDeMoをベースに、モメンタムをローカル成分と異なるトレーナー間で共有される成分に分割する新しいオプティマイザを開発しました。これは、ノード間で共有しなければならないデータ量を制限することにより、ノード間で必要な通信量を削減します。

DeMOは、GPUの各反復中に最も速く変化するパラメータに選択的に焦点を当てます。ロジックは単純で、変化の激しいパラメーターは学習にとって重要であり、優先順位の高いワーカー間で同期されるべきです。同時に、変化の遅いパラメータは、収束に大きな影響を与えることなく、一時的に遅延させることができます。Nousはまた、送信されるデータ量をさらに減らすために、JPEGが画像を圧縮する方法に似た離散コサイン変換(DCT)法を含む圧縮技術を採用している。最も重要な更新だけを同期させることで、DeMOは通信のオーバーヘッドを10~1000分の1(モデルサイズによる)に削減します。基礎となる最適化の完全な技術的概要については、Nous Researchの のブログ投稿をご覧ください。

2024年6月、Nousチームは2つ目の大きなイノベーションである分散トレーニングオプティマイザー(DisTro)を発表しました。2024年12月、NousはDisTroを使用して、LlaMAのようなアーキテクチャ上で150億のパラメータを含むモデルを訓練することで、このアプローチの実現可能性を実証しました。

Psyche

今年5月、NousはPsycheをリリースしました。Psycheの主な技術的アップグレードには、GPUが次のトレーニングステップを開始する際にモデルの更新を送信できるようにすることで、非同期トレーニングを改善することが含まれます。Psycheはまた、DisTroによって導入された圧縮技術をさらに改良し、通信負荷をさらに3分の1に削減しました。

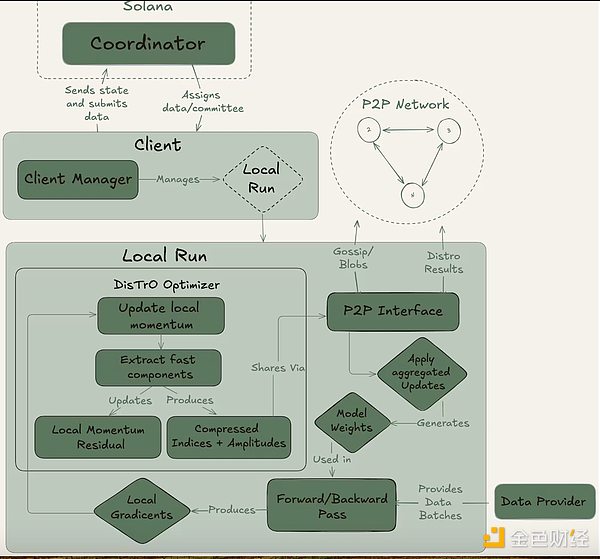

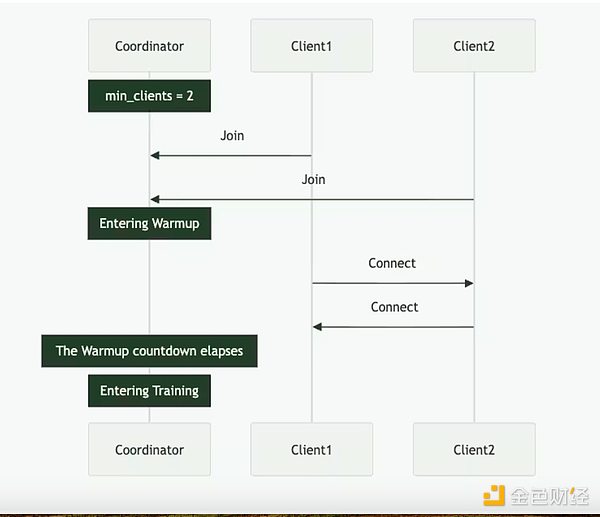

Psycheは、完全にオンチェーン(Solana経由)でもオフチェーンでも実装できます。コーディネータ、クライアント、データプロバイダの3つの主要プレーヤーで構成される。コーディネータは、モデルの最新の状態、参加クライアント、データの割り当てや出力の検証など、トレーニングの実行を促進するために必要なすべての情報を格納します。クライアントは、トレーニング実行中にトレーニングタスクを実行する実際のGPUプロバイダーである。モデルのトレーニングに加え、立会プロセス(後述)にも参加します。データプロバイダー(クライアント自身が保存可能)はトレーニングに必要なデータを提供します。

サイケでは、トレーニングをエポックとステップの2つのフェーズに分けています。この構造により、フル稼働のためにリソースを投入できないGPUプロバイダーの機会コストを最小限に抑えることができます。

サイケでは、トレーニングをエポックとステップの2つのフェーズに分けています。この構造により、フル稼働のためにリソースを投入できないGPUプロバイダーの機会コストを最小限に抑えることができます。

エポックの最初に、コーディネータが主要なパラメータを定義します:モデルアーキテクチャ、使用するデータセット、必要なクライアント数です。このとき、クライアントは最新のモデルのチェックポイントに同期される。チェックポイントは公開ソースから取得することも、他のクライアントからピアツーピアで同期することもできる。トレーニングが開始されると、各クライアントにはデータの一部が割り当てられ、ローカルでトレーニングが行われる。更新を計算した後、クライアントはその結果を暗号化された約束(作業が正しく行われたことを証明するSHA-256ハッシュ)とともにネットワークの残りの部分にブロードキャストする。

クライアントの一部はラウンドごとにランダムに選ばれ、証人として機能し、Psycheの主要な検証メカニズムとして機能する。これらの証人は通常通りトレーニングを行うが、どのクライアントの更新が受信され、有効であるかも検証する。これらのクライアントは、コーディネータにブルーム・フィルタを提出する。ブルーム・フィルタは、これらのエンゲージメントを効果的に集約する軽量なデータ構造である。Nous自身は、このアプローチが誤検出を生む可能性があるため完璧ではないことを認めているが、研究者たちは効率のためにこのトレードオフを喜んで受け入れている。特定のアップデートのために定足数の証人が確認されると、コーディネーターはグローバルモデルにアップデートを適用し、次のラウンドに移る前にすべてのクライアントにモデルの同期を取らせる。

重要なことに、Psycheの設計では、トレーニングと検証を重複させることができます。クライアントがアップデートを提出するとすぐに、コーディネーターや他のクライアントが前のラウンドのトレーニングを完了するのを待つことなく、次のバッチのトレーニングを開始することができます。このオーバーラップ設計とDisTrOの圧縮技術を組み合わせることで、通信のオーバーヘッドを最小限に抑え、GPUがアイドル状態にならないようにしています。

2025年5月、Nous Researchはこれまでで最大規模のトレーニングを開始します。分散型トレーニング・ネットワークで約20兆トークンを事前トレーニング。トレーニングはまだ進行中である。これまでのところ、実行はほぼ順調だが、最適化の軌道が収束から一時的に逸脱したことを示す損失スパイクがいくつか発生している。これは、勾配パラダイムが平均から数標準偏差の範囲にある損失や更新を自動的にスキップし、将来の損失スパイクのリスクを低減するものです。

2025年5月、Nous Researchはこれまでで最大規模のトレーニングを開始します。分散型トレーニング・ネットワークで約20兆トークンを事前トレーニング。トレーニングはまだ進行中である。これまでのところ、実行はほぼ順調だが、最適化の軌道が収束から一時的に逸脱したことを示す損失スパイクがいくつか発生している。これは、勾配パラダイムが平均から数標準偏差の範囲にある損失や更新を自動的にスキップし、将来の損失スパイクのリスクを低減するものです。

ソラナの役割

Psycheはオフチェーン環境でも実行できますが、ソラナでの使用を目的としています。Solanaはネットワークを訓練するための信頼と説明責任のレイヤーとして機能し、顧客のコミットメント、証人の証明、訓練メタデータをオンチェーンで記録します。これにより、トレーニングの各ラウンドの改ざん防止監査証跡が作成され、誰が貢献し、何が行われ、検証に合格したかどうかを透過的に検証できるようになる。

Nousはまた、トレーニング報酬の分配を容易にするためにSolanaを使用する予定です。プロジェクトはまだ正式なトークンエコノミクスを発表していないが、Psycheのドキュメントには、コーディネーターが顧客の計算貢献を追跡し、検証された作業に基づいてポイントを割り当てるシステムの概要が記載されている。これらのポイントは、チェーン上でホストされる金融スマートコントラクトとして機能することで、トークンと交換することができる。Psycheはまだトレーニングでこの報酬メカニズムを使用していないが、このシステムはNous暗号トークンの配布において中心的な役割を果たすと期待されている。

Hermesモデルファミリー

これらの研究貢献に加えて、NousはHermesファミリーのコマンド2024年8月、チームはLlama 3.1にファインチューニングされた完全パラメトリック・モデルのスイートであるHermes-3をリリースし、比較的小規模ではあるものの、プロプライエタリな大規模モデルに匹敵するパブリック・リーダーボードでの競争力を獲得しました。

最近では、2025年8月に、NousはHermes-4モデルファミリーをリリースしました。Hermes-4は、モデルのステップバイステップの推論能力を向上させることに重点を置き、通常の命令実行にも優れています。Hermes-4は、数学、プログラミング、理解、一般知識のテストに優れています。Nousのオープンソースの使命に従い、チームはHermes-4モデルの重みをすべて公開し、すべての人が使用、構築できるようにしました。さらに、NousはNous Chatと呼ばれるモデルアクセシビリティインタフェースをリリースし、リリース後1週間で自由に利用できるようになりました。

エルメス・モデルのリリースは、モデル構築組織としてのヌースの信頼性を確固たるものにするだけでなく、その幅広い研究課題を実践的に検証するものでもある。エルメスがリリースするたびに、最先端の能力がオープンな環境で実装できることを証明し、チームのブレークスルー(DeMo、DisTrO、Psyche)のための分散型トレーニングを提供し、最終的には野心的なコンシリエンス40Bの実行につながった。

Atropos

上述したように、推論モデリングの進歩や事前学習のスケーリングの制限により、強化学習はポストトレーニングにおいてますます重要な役割を果たしています。Atroposは分散環境における強化学習のためのNousのソリューションです。AtroposはNousの分散環境における強化学習ソリューションです。 LLMのためのプラグアンドプレイのモジュール式強化学習フレームワークであり、様々な推論バックエンド、学習方法、データセット、強化学習環境に適応することができます。

強化学習のポストトレーニングに多数のGPUを分散型で使用する場合、トレーニングプロセス中にモデルによって生成される即時出力は、完了時間が異なります。atroposはロールアウト・プロセッサ、すなわちデバイス間のタスク生成と完了を調整する中央コーディネータとして機能し、非同期強化学習トレーニングを可能にする。

Atroposの初期バージョンは4月にリリースされましたが、現在のところ、強化学習タスクを調整するための環境フレームワークのみが含まれています。 Nousは、今後数ヶ月のうちに追加のトレーニングおよび推論フレームワークをリリースする予定です。

背景

プライム・インテレクトは、大規模な分散型AI開発インフラを構築するために2024年に設立されました。Vincent Weisser氏とJohannes Hagemann氏によって共同設立されたこのチームは、当初、高度なAIモデルの共同分散トレーニングをサポートするために、集中型プロバイダーと分散型プロバイダーの計算リソースを統合することに注力しています。Prime Intellectの使命は、世界中の研究者や開発者がスケーラブルな計算リソースにアクセスし、オープンなAIイノベーションを共有所有できるようにすることで、AI開発を民主化することです。

OpenDiLoCo、INTELLECT-1、PRIME

2024年7月。プライムインテレクトは、Google DeepMindが開発したデータ並列訓練用の低通信モデル訓練手法であるDiLoCoのオープンソース版であるOpenDiLoCoをリリースした。Googleは、"現代の規模での標準的なバックプロパゲーションによるトレーニングは、前例のないエンジニアリングとインフラストラクチャの課題を提起する......多数のアクセラレータを調整し、緊密に同期させることは困難である "という考えに基づいて、このモデルを開発した。 この声明は、オープンソース開発の精神よりも、大規模トレーニングの実用性に焦点を当てていますが、長期的な集中型トレーニングの限界と、分散型の代替手段の必要性を暗黙のうちに認めています。

DiLoCoは、モデルのトレーニング時にGPU間で共有される情報の頻度と量を減らします。集中型セットアップでは、GPUはトレーニングの各ステップ後に更新されたすべての勾配を互いに共有します。DiLoCoでは、更新された勾配を共有する頻度を減らし、通信のオーバーヘッドを削減します。つまり、個々のGPU(またはGPUのクラスタ)は、各ステップ後に自身のモデルの重みを更新する内部最適化を実行し、外部最適化では、内部最適化がGPU間で共有され、その変更ですべてのGPUが更新されます。

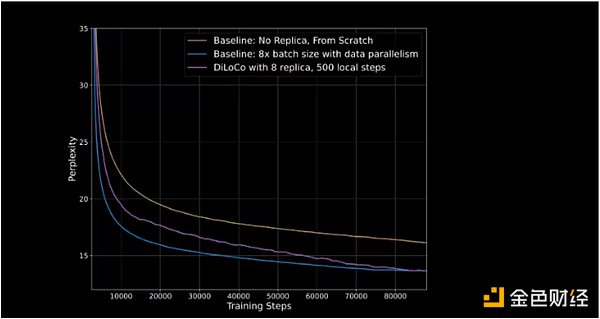

OpenDiLoCoは、初期リリースで90%から95%のGPU利用率を実証しました。これは、2つの大陸と3つの国にまたがっているにもかかわらず、アイドル状態のマシンがほとんどないことを意味します。OpenDiLoCoは、通信を500分の1に削減しながら、同等のトレーニング結果とパフォーマンスを再現することができました(下のグラフで紫色の線が青色の線に追いついていることが示しています)。

縦軸はPerplexityを表します。Perplexity が低いほど、モデルの予測はより確実で正確です

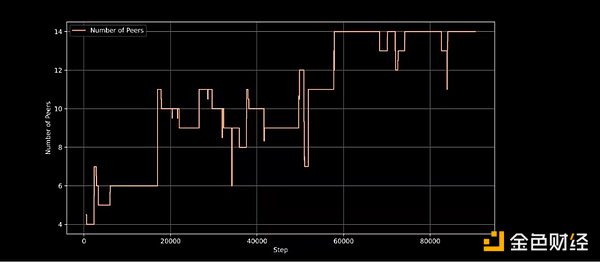

2024年10月、Prime IntellectはINTELLECT-1 >のトレーニングを開始します。、分散方式で訓練された最初の100億パラメータ言語モデルです。トレーニングには42日間を要し、モデルはその後オープンソース化された。トレーニングは3大陸の5カ国で行われた。トレーニングの実行により、分散トレーニングの漸進的な向上が実証され、米国内だけで、すべての計算リソースの利用率が83%、ノード間通信の利用率が96%に達した。このプロジェクトでは、暗号GPU市場のAkash、Hyperbolic、Olasを含むWeb2およびWeb3プロバイダーのGPUが使用されました。

INTELLECT-1は、Prime Intellectの新しいトレーニングフレームワークであるPRIMEを使用しています。これにより、Prime Intellectのトレーニングシステムは、計算が予期せず進行中のトレーニングに入ったり出たりした場合でも適応できるようになっています。.また、ElasticDeviceMeshのような革新的な技術も導入しており、貢献者はいつでも参加したり離脱したりすることができます。

トレーニング・ステップにおけるアクティブなトレーニング・ノード。

INTELLECT-1は、Prime Intellectの分散型トレーニング手法の重要な検証であり、ジャック・クラーク(Anthropicの共同創設者)などのAIオピニオンリーダーから、分散型トレーニングの実行可能なデモンストレーションであると評価されています。分散型トレーニングの実行可能なデモンストレーションであると考えられています。

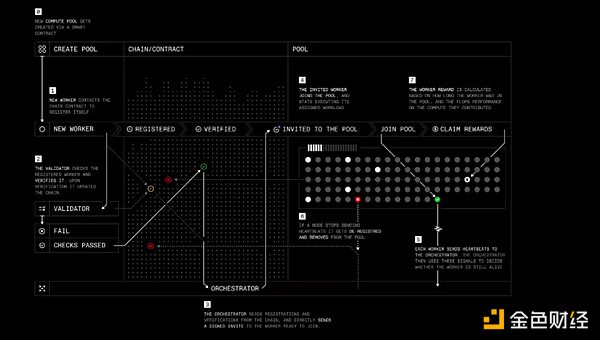

プロトコル

今年2月、プライムインテレクトはプロトコルによってスタックに別のレイヤーを追加しました。Protocolは、Prime Intellectのすべてのトレーニングツールを接続し、分散型モデルトレーニングのためのピアツーピアネットワークを構築します。これには以下が含まれます:

Compute Swapping GPUsにより、トレーニングの実行が容易になります。

PRIMEトレーニングフレームワークは、通信オーバーヘッドを削減し、フォールトトレランスを向上させます。

RLの微調整に役立つ、合成データの生成と検証のためのGENESYSと呼ばれるオープンソースライブラリ。

参加ノードからのモデル実行と出力を検証するためのTOPLOCと呼ばれる軽量検証システム。

Protocol はNousのPsycheに似た役割を果たします。

Workers: ユーザーがトレーニングや他のPrime Intellect AI関連製品のためにコンピューティングリソースを提供できるようにするソフトウェアの一部です。

Validator: 計算貢献を検証し、悪意のある振る舞いを防止します。Prime Intellectは、最先端の推論検証アルゴリズムTOPLOCを分散型トレーニングに適用することに取り組んでいます。

Orchestrator: 計算プール作成者の作業負荷を管理する方法。Nousのオーケストレーターと同様の働きをします。

スマートコントラクト:計算リソース提供者を追跡し、悪意のある参加者からの誓約を削減し、報酬を自律的に支払う。現在、Prime IntellectはイーサネットL2ベース上のSepoliaテストネット上で稼働しているが、Prime Intellectは最終的に独自のブロックチェーンに移行する計画を示している。

ステップ・バイ・ステップのプロトコル・トレーニング

ステップ・バイ・ステップのプロトコル・トレーニング

プロトコルは、最終的には貢献者がプロトコルを利用できるようにすることを目指しています。Protocolは、最終的には貢献者がモデルの株を所有したり、自分の仕事に対して報酬を得られるようにすることを目指しており、その一方で、スマートコントラクトや集団的インセンティブを通じて、オープンソースのAIプロジェクトが開発に資金を供給し、管理するための新しい方法を提供します。

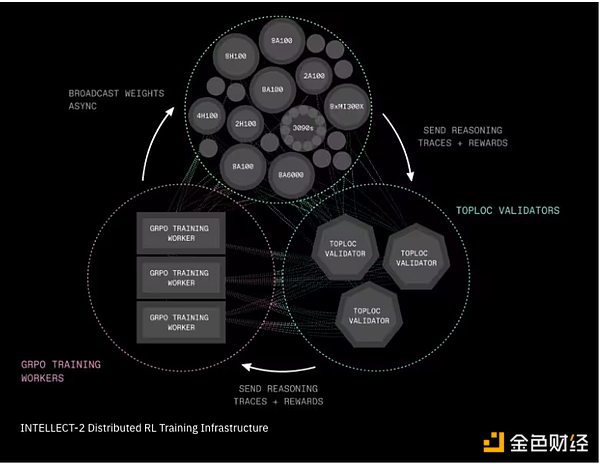

INTELLECT 2と強化学習

4月、Prime?INTELLECT-1はベースモデルのトレーニングに重点を置いていますが、INTELLECT-2は強化学習を使って、別のオープンソースモデル(AlibabaのQwQ-32B)の推論モデルをトレーニングします。

研究チームは、この分散型RLトレーニングを実用化するために、次の2つの重要なインフラコンポーネントを導入しました。完全に非同期の強化学習フレームワークであり、学習プロセスを3つの別々のフェーズに分割します:回答候補の生成、選択された回答に対するトレーニング、更新されたモデルの重みのブロードキャストです。この分離メカニズムにより、システムは信頼性の低い、低速な、あるいは地理的に分散したネットワークにも対応することができる。トレーニング・プロセスでは、プライム・インテレクトのもうひとつの革新的技術であるGENESYSを使用して、答えが正しいか正しくないかを即座に判断できる自動チェッカーとともに、何千もの数学、論理、コーディングの問題を生成します。 各マシンが中央サーバーからアップデートをダウンロードするのではなく、SHARDCASTはマシン間でアップデートを共有する構造を採用しています。これにより、ネットワークの効率性、高速性、耐障害性が保たれます。

Intellect-2分散強化学習トレーニング基盤

Intellect-2分散強化学習トレーニング基盤

INTELLECT-2では、トレーニング実行に参加するために、貢献者はtestnet暗号トークンを誓約する必要があります。有効な仕事に貢献すれば、自動的に報酬が支払われる。そうでない場合は、誓約が減額される可能性がある。このテストランでは実際の金銭は関与していないが、暗号経済実験の初期形態の一部を浮き彫りにしている。この分野ではさらなる実験が必要であり、セキュリティやインセンティブという点で、暗号経済の応用におけるさらなる変化が予想される。プライム・インテレクトは、INTELLECT-2に加えて、本レポートでは取り上げていないいくつかの重要なイニシアチブを継続しています。strong>は、推論タスクの生成と検証のための次世代フレームワークです。

Prime Collective Communications Libraryは、効率的で耐障害性のある集団通信操作(IP上でのスケールダウンなど)を実装しています。プライム集団通信ライブラリは、効率的で耐障害性のある集団通信操作(IP経由でのスケールダウンなど)を可能にし、ピアの同期を維持する共有状態同期メカニズムを提供し、トレーニング中にいつでもライブラリにピアを動的に追加および削除できるようにします。)

INTELLECT2とSYNTHETIC1から学んだ教訓に基づく、Prime Intellectプロトコルと暗号経済レイヤーの改良。研究

アレクサンダー・ロングはオーストラリアの機械学習研究者で、ニューサウスウェールズ大学で博士号を取得しています。

2023年4月、彼は別の道を切り開く目的でPluralis Researchを設立しました。

プラリスリサーチは、「低帯域幅、異種多参加型」と説明される「プロトコル学習」と呼ばれるアプローチを使って、分散型トレーニングの問題を解決します、Pluralisの主な特徴は、その経済モデルである。このモデルは、トレーニングモデルの貢献者に平等のような見返りを提供することで、計算貢献を奨励し、トップクラスのオープンソースソフトウェア研究者を惹きつける。この経済モデルは、「非抽出性」という核となる特性を前提としています。つまり、一人の参加者が重みの完全なセットにアクセスすることはなく、これはトレーニング方法論とモデルの並列性の使用に結びついています。

モデル並列性

Pluralisのトレーニングアーキテクチャはモデル並列性を利用しており、これはNous ResearchとPrime Intellectによる最初のトレーニングで使用されたモデル並列性に似ています。Prime Intellectのデータ並列性アプローチは、最初のトレーニング実行で実装されました。モデルのサイズが大きくなると、H100ラック(最も先進的なGPU構成の1つ)でさえ、フルモデルを搭載するのに苦労します。モデル並列処理では、1つのモデルの各コンポーネントを複数のGPUに分割することで、この問題を解決します。

モデル並列化には主に3つのアプローチがあります。

Pipeline parallelism (パイプライン並列処理): モデルの各層は異なるGPUに分割されます。

テンソル(レイヤー内)並列性:各GPUにレイヤー全体を提供する代わりに、各レイヤー内の重い数学演算を分離し、複数のGPUが同時に1つのレイヤーの作業を分担できるようにします。

ハイブリッド並列:実際には、大規模モデルでは、パイプライン並列とテンソル並列の両方を使用し、多くの場合、データ並列と組み合わせた、さまざまなアプローチを組み合わせて使用します。

モデル並列性は、最先端のスケールモデルのトレーニングを可能にし、低層のハードウェアの参加を可能にし、単一の参加者がモデルの重みのフルセットにアクセスできないようにするため、分散トレーニングにおける重要な進歩です。

プロトコル学習とプロトコルモデル

プロトコル・ラーニングは、分散型トレーニング環境におけるモデルの所有と収益化のためのPluralisのフレームワークです。Pluralisは、プロトコル・ラーニングのフレームワークを構成する3つの重要な原則、分散化、インセンティブ付与、脱信頼を強調しています。

Pluralisと他のプロジェクトの主な違いは、モデルの所有権に焦点を当てていることです。モデルの価値はその重みに由来するところが大きいため、プロトコルモデル(ProtocolModels)はモデルの重みを分割し、モデル訓練プロセスの参加者がすべての重みを所有しないようにしようと試みています。最終的に、これはトレーニングモデルへの各貢献者に一定レベルの所有権を与え、その結果、モデルによって生成される収益の分け前を与えることになる。

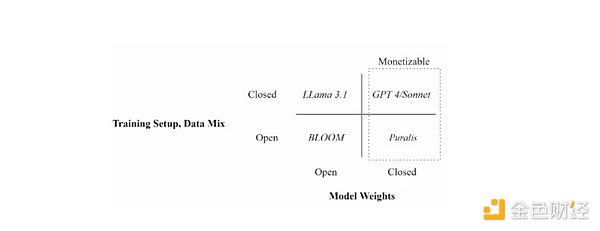

トレーニング設定(オープンデータとクローズドデータ)およびモデル重みの利用可能性(オープンとクローズド)

トレーニング設定(オープンデータとクローズドデータ)およびモデル重みの利用可能性(オープンとクローズド)

これは分散型モデル経済に対する、これまでの例とは根本的に異なるアプローチです。他のプロジェクトでは、特定の指標(通常は貢献した時間や計算能力)に基づいてトレーニングサイクル中に貢献者に割り当てられる資金プールを提供することで、貢献にインセンティブを与えます。パフォーマンスの低いモデルは収益を生まないため、パフォーマンスの低いモデルのトレーニングは、計算能力、エネルギー、時間を浪費します。

これは2つの点で以前のアプローチと異なります。第一に、モデルのトレーニングを希望する個人が、貢献者に支払う初期資金を調達する必要がないため、モデルのトレーニングと開発に対する障壁が低くなります。第二に、モデル設計者と計算機提供者の間のインセンティブをよりよく整合させることである。また、モデルのトレーニングに専門性が生まれる可能性もある。例えば、より大きなリターンを求めて(ベンチャーキャピタリストに似ている)初期モデルや実験的モデルに対して計算サービスを提供するリスク許容度の高いトレーナーが存在する一方、(プライベートエクイティ投資家に似ている)計算プロバイダーは成熟し、適用される可能性の高いモデルのみに焦点を当てるかもしれない。

PMは、分散型トレーニングの収益化とインセンティブ付与における大きなブレークスルーを示すかもしれませんが、Pluralisはまだその正確な実装について詳しく説明していません。このアプローチが非常に複雑であることを考えると、モデルの所有権をどのように割り当てるか、収益をどのように分配するか、さらにはモデルの将来のアップグレードやユースケースをどのように管理するかなど、対処すべき問題が残っている。

分散型トレーニングイノベーション

経済的な考慮に加えて、プロトコル(ProtocolLearning)は、他の分散型トレーニングプロジェクトと同じ核となる課題に直面しています。つまり、通信制約のある異種GPUネットワークを使用して大規模なAIモデルをトレーニングするということです。

今年6月、PluralisはMetaのLlama 3アーキテクチャに基づく80億パラメータのLLMのトレーニングに成功したことを発表し、そのプロトコルモデル論文を発表しました。論文の中でPluralis社は、モデルの並列学習を行うGPU間の通信オーバーヘッドを削減する方法を示した。これは、各Transformerレイヤーを流れる信号を、事前に選択されたマイクロサブジェクトの小さな部分空間に制限し、フォワードパスとバックワードパスを最大99%圧縮することで、精度を損なわず、オーバーヘッドを大幅に追加することなく、ネットワークトラフィックを100分の1に削減する。要するに、Pluralisは同じ学習情報を、以前の手法で必要とされた帯域幅の何分の一かに圧縮する方法を発見したのです。

これは初の分散型トレーニング実行であり、モデル自体は複製されるのではなく、低帯域幅で接続されたノードに分散されました。研究チームは、1日あたり80メガビット/秒の家庭用インターネット接続のみで接続された、4つの大陸に分散したローエンドのコンシューマーグレードGPUで、80億のパラメーターを持つLlamaモデルの学習に成功した。この論文でPluralis社は、このモデルが100Gb/秒のデータセンターで実行した場合と同様に収束することを実証した。これは、大規模モデルの並列分散型トレーニングが可能になったことを意味する。

最後に、パイプライン並列トレーニングのための非同期トレーニングに関するPluralisの論文は、7月に主要なAI会議の1つであるICMLでアクセプトされました。パイプライン並列トレーニングが高速データセンターではなくインターネット上で行われる場合、ノードは本質的に組み立てラインに似た方法で動作するため、同じ通信ボトルネックに直面する。これは、勾配の陳腐化と情報伝達の遅延につながる。この論文で実証された分散型トレーニングフレームワークであるSWARMは、一般的にGPUがトレーニングに参加することを妨げる2つの古典的なボトルネックを取り除きます。この2つのボトルネックを解消することで、利用可能なGPUをすべて有効活用できるようになり、トレーニング時間を短縮し、コストを削減することができます。これは、ボランティアベースの分散型インフラストラクチャを使用して大規模モデルをスケーリングする上で非常に重要です。このプロセスの概要については、Pluralis社のビデオをご覧ください。

今後の展望として、Pluralisは誰でも参加できるリアルタイムのトレーニングを近々開始する予定だが、具体的な日付はまだ決めていないと述べている。このリリースでは、特に経済モデルや暗号インフラなど、まだリリースされていないプロトコルの側面をより深く理解することができる。

背景

テンプラーは11月20日にローンチされました。2024年11月にローンチされたTemplarは、Bittensorプロトコルのサブネットをベースにしたインセンティブ主導の分散型AIタスクマーケットプレイスです。ライセンスフリーのAI事前トレーニングのためにグローバルなGPUリソースをプールする実験的なフレームワークとして始まり、Bittensorのトークン化されたインセンティブを通じて、大規模なモデルトレーニングを利用しやすく、安全で、回復力のあるものにすることで、AI開発を再定義することを目指しています。

当初から、Templarはインターネット上でLLM事前トレーニングの分散型トレーニングを調整するという課題に取り組んできました。遅延、帯域幅の制限、異種ハードウェアのため、分散参加者が集中型クラスタの効率を達成するのは困難であり、シームレスなGPU通信によって大規模モデルの迅速な反復が可能になる。

非常に重要なのは、Templarは真にパーミッションのない参加を優先することで、計算リソースがあれば誰でも、承認、登録、ゲートキーピングなしでAIトレーニングに参加できるようにしていることです。このパーミッションレス・アプローチは、AI開発を民主化するというテンプラーのミッションにとって非常に重要です。画期的なAI能力が少数の中央集権的な団体によって管理されるのではなく、オープンなグローバル・コラボレーションから生まれることを保証するからです。

Templar トレーニング

Templarは、主に次の2つの要素をトレーニングするために、並行してデータを使用します。

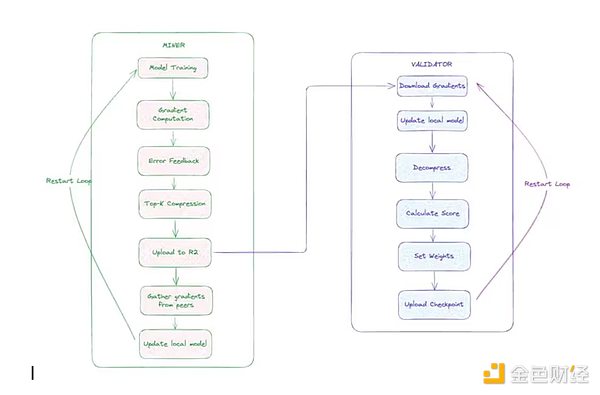

Miners: これらの参加者はトレーニングタスクを実行します。各マイナーは、最新のグローバルモデルと同期し、ユニークなデータスライスを取得し、フォワードパスとバックワードパスを使用してローカルにトレーニングし、カスタムCCLocoオプティマイザ(後述)を使用して勾配を圧縮し、勾配の更新を提出する。

バリデーター:バリデーターはマイナーによって提出されたアップデートをダウンロードして解凍し、モデルのローカルコピーに適用し、損失増分(モデルがどれだけ改善されたかの尺度)を計算します。これらの増分は、TemplarのGauntletシステムを通じてマイナーたちの貢献を採点するために使用される。

通信のオーバーヘッドを減らすために、Templarの研究チームはまずブロック圧縮DiLoCo(CCLoco)を開発しました。Nousと同様に、CCLocoはGoogleのDiLoCoフレームワークのような通信効率の高いトレーニング技術を改良することで、ノード間通信のコストを数桁削減し、そのような手法がしばしば引き起こす損失を低減しています。意味のあるデータが失われないようにするためである。このシステムは、報酬を受け取るために低遅延更新を提供するようマイナーにインセンティブを与える競争ベースのモデルを使用している。報酬を得るためには、採掘者は効率的なハードウェアを導入してネットワークに追いつかなければならない。この競争構造は、十分なパフォーマンスを維持できる参加者のみがトレーニングプロセスに参加できるように設計されており、一方で軽量の健全性チェックが、明らかに不良なアップデートや誤ったフォーマットのアップデートをフィルタリングします。8月、Templarはアップデートされたトレーニングアーキテクチャを正式にリリースし、SparseLoCo.

検証者は、TemplarのGauntletシステムを使用して、観察されたモデルの損失削減貢献に基づいて、各マイナーのスキル評価を追跡し、更新します。OpenSkillと呼ばれる技術により、一貫して有効なアップデートを行う高品質のマイナーは、より高いスキル評価を受け、それによってモデル集約への影響力を高め、より多くのTAO(Bittensorネットワークのネイティブトークン)を獲得する。レーティングが低いマイナーは、アグリゲーションプロセス中に破棄されます。レーティング後、最も高い誓約を持つ検証者が、上位ランクのマイナーからの更新を集約し、新しいグローバルモデルに署名し、ストレージに公開する。同期していないモデルがある場合、採掘者はこのバージョンのモデルを使用して追いつくことができる。

Templar分散型トレーニング・アーキテクチャ

Templar分散型トレーニング・アーキテクチャ

テンプルは、3つのラウンドを開始しました。Templarは現在までに、Templar I、Templar II、Templar IIIという3つのトレーニングラウンドを開始しました。 Templar Iは12億パラメータのモデルで、200近くのGPUがグローバルに展開されました。Templar IIは現在進行中で、80億パラメータのモデルをトレーニングしており、間もなく大規模なトレーニングを開始する予定です。Templarが現段階でより小さなパラメーターのモデルのトレーニングに重点を置いているのは、より大きなモデルサイズにスケールアップする前に、分散型トレーニングアーキテクチャーのアップグレード(上述)が効果的に機能するようにするための意図的な選択である。戦略やスケジューリングの最適化から反復やインセンティブの調査まで、より小さなパラメーターを持つ80億のモデルでこれらのアイデアを検証することで、チームは迅速かつコスト効率よく反復を行うことができる。最近の進展とトレーニング・アーキテクチャの正式リリースに続き、チームは9月にTemplar IIIを発表した。これは700億のパラメーターを持つモデルで、分散化におけるこれまでの最大規模の事前トレーニング実行である。

TAOとインセンティブ

テンプラーの重要な特徴は、TAOモデルと結びついたインセンティブです。モデルです。インセンティブは、モデルのトレーニングに対するスキル加重の貢献度に基づいて分配されます。ほとんどのプロトコル(Pluralis、Nous、Prime Intellectなど)は、ライセンスの下、あるいはプロトタイプとして動作するように構築されているが、TemplarはBittensorのリアルタイムネットワーク上で完全に動作する。これにより、Templarはリアルタイムでライセンスフリーの経済レイヤーを分散型トレーニングフレームワークに統合した唯一のプロトコルとなる。このリアルタイムの本番展開により、Templarはリアルタイムのトレーニング実行シナリオでインフラを反復することができる。

各Bittensorサブネットは独自の「アルファ」トークンで運用され、報酬メカニズムとサブネットの価値を認識するための市場シグナルとして機能します。Templarのアルファトークンはガンマと呼ばれる。アルファトークンは外部市場で自由に取引されることはなく、自動マーケットメーカー(AMM)を使ってサブネット専用の流動性プールを通じてのみTAOと交換することができる。BittensorのダイナミックTAO(dTAO)システムは、アルファトークンの市場価格を使用して、サブネット間の発行の配分を決定します。ガンマの価格が他のアルファトークンと比較して上昇した場合、それはTemplarの分散型トレーニング能力に対する市場の信頼が高まったことを示し、サブネットへのTAO発行の増加につながります。9月上旬の時点で、Templarの毎日の発行はTAO発行の約4%を占め、TAOネットワーク上の128のサブネットのうち上位6位にランクされています。

サブネットの発行メカニズムは以下の通りです:各12秒ブロックにおいて、Bittensorチェーンは、他のサブネットとの相対的なサブネットのアルファトークンの価格に対するサブネットのアルファトークンの比率に基づいて、流動性プールにTAOとアルファトークンを発行します。サブネットの貢献者にインセンティブを与えるため、1ブロックにつき最大1つのフルアルファトークンがサブネットに発行され(最初の発行率は半分になる可能性がある)、そのうち41%がマイナーに、41%が検証者(およびその誓約者)に、18%がサブネットの所有者に割り当てられる。

このインセンティブメカニズムは、参加者が提供する価値に金銭的報酬を結びつけることで、Bittensorネットワークへの貢献を促進します。マイナーは、モデルのトレーニングや推論タスクなど、高品質のAIアウトプットを提供するインセンティブを与えられ、バリデータからより高い評価を得ることができ、その結果、アウトプットのシェアが大きくなります。バリデーター(およびその誓約者)は、ネットワークの整合性を正確に評価し、維持することで報酬を得る。

アルファトークンの市場評価は誓約活動によって決定され、より高い有用性を示すサブネットワークがより多くのTAOの流入と発行を引き寄せるようにすることで、革新、専門化、継続的な成長を促す競争環境を作り出します。サブネットの所有者は報酬の一定割合を受け取るため、効果的なメカニズムを設計し、貢献者を引き付けるインセンティブを得ることができ、最終的にはライセンスの必要のない分散型AIエコシステムを構築し、集合知の進歩に貢献するグローバルな参加を可能にする。

このメカニズムはまた、検証者を正直に保ち、魔女狩りをかわし、談合を減らすといった新たなインセンティブ課題も導入している。サブネット作成者はそれを阻止しようとする。長い目で見れば、サブネットの所有者が悪意のあるアクターを出し抜く方法を学ぶにつれ、こうした闘いによって、このシステムは最も強固なものになるはずだ。

Gensynは、2022年2月に最初の合理化されたホワイトペーパーをリリースし、分散型トレーニングのフレームワークを提示した(Gensynは、昨年の我々の暗号とAIの交差点を理解する上で、Gensynは唯一の分散型トレーニング・プロトコルとして取り上げられました)。当時、このプロトコルは主にAI関連のワークロードの検証に重点を置いており、ユーザーがネットワークにトレーニングリクエストを提出し、コンピュートプロバイダによって処理され、約束通りに実行されることを確認できるようになっていた。

当初のビジョンでは、応用機械学習(ML)研究を加速させる必要性も強調されていました。2023年、Gensynはこのビジョンに基づき、機械学習コンピュートリソースへのグローバルなアクセスの必要性を明確にし、サービスを提供しました。Gensynは、このようなプロトコルが満たさなければならないフレームワークとして、GHOSTLY原則を導入しました:一般性、異種性、オーバーヘッド、スケーラビリティ、非信頼性、およびレイテンシです。gensynは、コンピュート・インフラストラクチャーの構築に注力しており、このコラボレーションは、コンピュートだけでなく、他の重要なリソースへの正式な拡張を意味します。

ジェンシンの中核は、そのトレーニング技術スタックを4つの異なる部分-実行、検証、通信、調整-に分けています。実行部分は、機械学習オペレーションを実行できる世界中のあらゆるデバイス上でのオペレーション処理を担当します。通信とオーケストレーションの部分は、デバイスが標準化された方法で相互に情報を送信することを可能にする。バリデーション・コンポーネントは、すべてのオペレーションが信頼なく計算できることを保証する。

実行-RL Swarm

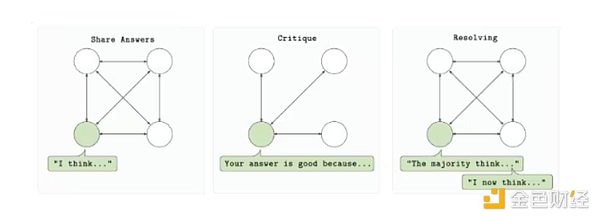

このスタックのGensynの最初の実装は、RL Swarmと呼ばれるアプリケーションです。このスタックの最初の実装はRL Swarmと呼ばれるトレーニングシステムで、トレーニング後の強化学習のための分散型調整メカニズムです。

RLスウォームは、ライセンスフリーの信頼最小化環境で、複数の計算プロバイダーが単一のモデルのトレーニングに参加できるように設計されています。プロトコルは、回答、レビュー、解決という3段階のサイクルに基づいている。まず、各参加者は、プロンプトに基づいてモデルの出力(回答)を生成する。次に、他の参加者が共有報酬関数を使ってこの出力を評価し、フィードバック(レビュー)を提出する。最後に、これらのレビューを使用して最良の答えを選択し、次のバージョンのモデルに組み込みます(解決)。すべてのプロセスはピアツーピアで行われ、中央のサーバーや信頼できる組織には依存しない。

RLスウォーム学習ループ

RLスウォーム学習ループ

強化学習。Swarmは、モデルのポストトレーニングにおける強化学習の重要性の高まりに基づいています。Gensynのシステムは、強化学習ループを役割に分解することで、分散環境でこの改善を達成し、それぞれが独立して検証できる。重要なのは、フォールト・トレラントな非同期実行を導入していることで、参加者が常にオンラインである必要も、参加するために完全に同期している必要もないことを意味している。

また、本質的にモジュール化されています。このシステムは、特定のモデルアーキテクチャ、データ型、報酬構造を使用する必要がないため、開発者はトレーニングループを特定のユースケースに合わせることができます。RL Swarmは、コード化されたモデル、推論エージェント、または特定の命令セットを持つモデルのいずれをトレーニングする場合でも、分散型RLワークフローを大規模に実行するための信頼性の高いフレームワークを提供します。

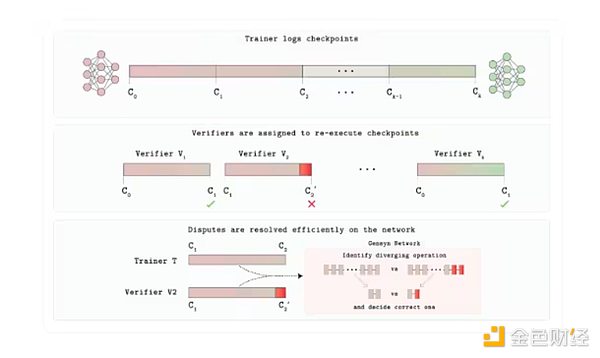

検証-Verde

今日まで、このレポートでは、分散型トレーニングの最も議論されていない側面の1つが検証です。これまでのところ、本レポートで分散型トレーニングについて最も議論されていない側面の1つが、GensynがGPU市場のために構築したVerde信頼レイヤーのVerdeです。Verdeによって、Gensynは新しい検証メカニズムを導入し、プロトコルの利用者が、相手側の人間が、彼らの言うとおりに行動していることを信頼できるようにする。

各トレーニングまたは推論タスクは、アプリによって決定された一定数の独立したプロバイダーにディスパッチされます。それらの出力が完全に一致する場合、タスクは受理されます。出力が異なる場合、レフェリー・プロトコルは2つの軌跡が分岐する最初のステップを特定し、その操作のみを再計算する。数字がレフェリーのものと一致した当事者は支払いを保持し、もう一方の当事者は持ち分を失う。

これを可能にしているのがRepOpsです。RepOpsは「繰り返し可能な演算子」のライブラリで、一般的なニューラルネットワークの数学演算(行列の乗算、活性化など)を、どのGPU上でも固定された決定論的な順序で実行させます。どのGPU上でも、決まった順序で実行されます。決定論はここで非常に重要です。そうでない場合、2つのバリデータはどちらも正しいにもかかわらず、異なる結果を出す可能性があります。したがって、正直なプロバイダーはビットごとに同一の結果を提供し、Verdeはそのマッチを正しさの証明として扱うことができる。レフェリーは1マイクロステップを再生するだけなので、追加されるコストは、このようなプロセスで通常使用される完全な暗号証明の10,000倍のオーバーヘッドではなく、わずか数パーセントポイントである。

バーデ認証プロトコル・アーキテクチャ

8月、ジェンシン社は検証可能なAI評価システムであるJudgeをリリースした。Judgeは、Verdeと、ハードウェア間でビットごとの同一結果を保証する再現可能なランタイムという2つのコア・コンポーネントを備えている。このシステムを実証するため、Gensynは、情報が明らかになるにつれてAIモデルが複雑な質問に対する答えに賭ける「プログレッシブ暴露ゲーム」を開始しました。

ジャッジが重要なのは、AI/MLにおける信頼性とスケーラビリティの問題に取り組んでいる点です。信頼性の高いモデル比較を可能にし、高ステーク環境における透明性を向上させ、独立した検証を可能にすることでバイアスや操作のリスクを低減します。推論タスクに加えて、Judgeは分散型紛争解決や予測市場などの他のユースケースをサポートすることができ、信頼できる分散型AIコンピューティング・インフラストラクチャを構築するというGensynのミッションに適合しています。最終的に、Judgeのようなツールは再現性と説明責任を強化し、AIがますます社会の中心に位置する時代には不可欠です。

通信と調整:Skip-Pipeと多様な専門家の統合

Skip-Pipeは、1つの巨大なモデルを複数のマシンでスライスして切り分けるという課題に対するGensynの答えです。複数のマシンでスライスする場合、モデルの帯域幅がボトルネックになります。skip-Pipeのスケジューラは、遅延の原因となるレイヤーを動的にスキップしたり、レイヤーを並べ替えたりすることで、反復時間を最大55%短縮し、ノードの半分が故障しても可用性を維持します。ノード間のトラフィックを減らし、必要に応じてレイヤーを削除できるようにすることで、トレーナーは非常に大きなモデルを地理的に分散したGPUに低帯域幅でスケーリングすることができます。

多様なエキスパートの統合は、もう1つの協調の課題である、絶え間ないクロストークを回避する堅牢な「ハイブリッド・エキスパート」システムを構築する方法を解決します。GensynのHeterogeneous Domain Expert Integration (HDEE)は、各エキスパートモデルを完全に独立してトレーニングし、最後にそれらを統合します。驚くべきことに、最終的な統合は、同じ全体的な計算予算で、テストされた21のドメインのうち20のドメインで、均一なベンチマークを上回った。トレーニング中にマシン間で勾配や活性化関数のフローが発生しないため、アイドル状態のGPUが計算能力に貢献できる。

Skip-PipeとHDEEは、Gensynに効率的な通信ソリューションを提供します。このプロトコルにより、必要なときに単一のモデル内でスライスしたり、独立性のコストを大幅に抑えながら複数の小さなエキスパートを並行してトレーニングしたりすることができます。

テストネット

3月、Gensynはカスタマイズされたイーサネット・ロールアップ上にテストネットを展開しました。チームはテストネットを徐々に更新していく予定です。現在、ユーザーはGensynの3つの製品、RL Swarm、BlockAssist、Judgeに参加することができる。前述の通り、RL Swarmでは、ユーザーはRLのポストトレーニングプロセスに参加することができる。8月、チームはBlockAssistを発表した。「アシステッド・ラーニングの最初の大規模なデモンストレーションであり、手作業によるラベリングやRLHFを必要とせず、人間の行動から直接エージェントを訓練する方法」である。ユーザーはマインクラフトをダウンロードし、BlockAssistを使ってマインクラフトモデルを訓練し、ゲームをプレイさせることができる。

上記のセクションでは、次のように説明しました。分散型トレーニングを可能にするために実装されている主要なアーキテクチャを概説した。しかし、新しいプロジェクトも登場しています。以下は、分散型トレーニングの分野における新しいプロジェクトのいくつかです:

Fortytwo: FortytwoはMonadブロックチェーンの上に構築されており、複数の小さな言語モデル(SLM)が協調する群推論(SLM)に焦点を当てています。複数の小型言語モデル(SLM)がノードのネットワーク上で協働してクエリを処理し、ピアレビューされた出力を生成することで、精度と効率を向上させます。このシステムは、アイドルノートPCのようなコンシューマーグレードのハードウェアを利用し、中央集権型AIのような高価なGPUクラスタを必要としない。このアーキテクチャには、分散型の推論実行機能と、専用モデル用の合成データセットの生成などのトレーニング機能が含まれている。このプロジェクトはMonad Development Networkで公開されています。

Ambient:Ambientは、間もなく発表される有用性の証明レイヤーです-1ブロックチェーンで、常時オン、常時利用可能、常時準備可能なブロックチェーンのために設計されています。Ambientは、まもなく開始される「有用性の証明」レイヤー -1ブロックチェーンであり、中央集権的な監視のない無許可のエコシステムにおいて、継続的にタスクを実行し、学習し、進化するために、チェーン上で常時自律的に稼働するAIエージェントをサポートするように設計されている。ネットワーク・マイナーによって共同で学習・改良される単一のオープンソースモデルが使用され、AIモデルの学習、構築、使用における貢献者には報酬が支払われる。Ambientは、特にエージェントに関して分散型の推論を重視しているが、ネットワーク上の採掘者は、ネットワークを支える基礎となるモデルを継続的に更新する責任も負う。Ambientは、新しいp roof- o f-logitsメカニズム(検証者が採掘者の生の出力値(logitsと呼ばれる)を検証できるシステム)を採用している。logitsと呼ばれる)を検証者が検証し、それがモデル計算を正しく実行したことを検証するシステム)。このプロジェクトはSolanaのフォーク上に構築されており、まだ公式には稼働していない。 Flower Labs: Flower LabsはFlowerに取り組んでいます。Flowerは、組織や個人がローカルデータ(ヘルスケアや金融領域など)を使用してモデルをトレーニングすることを可能にする一方で、安全なパラメータ共有を通じてグローバルな改善に貢献することで、データの集中化の問題に対処するために設立された。トークン報酬や検証可能な計算を重視する暗号ネイティブ・プロトコルとは異なり、Flowerは実世界のアプリケーションにおいてプライバシーを保護するコラボレーションを優先するため、ブロックチェーンを必要としない規制産業に理想的です。 Macrocosmos: Macrocosmos はBittensorネットワーク上で動作し、5つのサブネットにわたる完全なAIモデル作成プロセスを開発しています。これらのサブネットワークは、事前トレーニング、微調整、データ収集、分散型科学に焦点を当てている。ヘテロジニアスで信頼性が低く、ライセンス不要のハードウェア上で大規模な言語モデルを事前トレーニングするためのIncentive Orchestration Training Architecture(IOTA)フレームワークを導入しており、すでに10億以上のパラメータ・トレーニングを開始している。 Flock.io:Flockは分散型AIトレーニングエコシステムであり、Federated Learningとブロックチェーンインフラストラクチャを組み合わせ、トークンにインスパイアされたモジュール型ネットワークでプライバシーを保護したコラボレーションモデルを実現します!開発。参加者はモデル、データ、計算リソースを提供し、貢献度に比例した報酬をオンチェーンで受け取ることができる。データのプライバシーを保護するため、プロトコルは連合学習を使用する。これにより、参加者は他者と共有されないローカルデータを使ってグローバルモデルを訓練することができる。このセットアップでは、余計なデータ(しばしばデータポイズニングと呼ばれる)がモデルのトレーニングに入るのを防ぐために、追加の検証ステップが必要になるが、ヘルスケアアプリケーションのようなユースケースには効果的なロールアウトシナリオである。 過去2年間で、分散型トレーニングは興味深いコンセプトから、実世界の設定で動作する効果的なネットワークへと変貌を遂げました。これらのプロジェクトは、望ましい最終状態にはまだほど遠いものの、分散型トレーニングへの道筋において意義深い進歩を遂げている。 リアルタイムの概念実証は、もはや夢物語ではありません。この1年で、NousのConsilienceやPrime IntellectのINTELLECT-2のような初期のプルーフ・オブ・コンセプトは実稼働規模に移行し、OpenDiLoCoやProtocol Modelsのようなブレークスルーは、分散ネットワーク上での高性能AIを可能にし、費用対効果が高く、弾力性があり、透明性の高いモデル開発を促進しています。展望とリスク

調査の結果、このトレーダーは、グーグル・クローム・ブラウザのセキュリティ侵害が、特に特定の暗号ウォレット拡張機能を狙ったキーロガーによって実際に引き起こされたことを確認した。

Kikyo

KikyoIO.net、ビットコイン半減後のIOトークン発売を発表。ネットワーク機能の強化、パワーの分散化、コミュニティへの関与の促進を目指す。

Weiliang

WeiliangTON Blockchain Hackathonでのロバート・リーの投稿に端を発し、TON、HashKey、Oyster Labsのコラボレーションによる新しい「ユニバーサル・ベーシック・スマートフォン」についての憶測が渦巻いている。詳細は未確認のままだが、4月8日の正式予約開始への期待は高まっている。

Alex

AlexLumoz(旧Opside)が600万ドルの評価額を確保、Lumozトークン発売準備、開発者向けにzk-rollup技術の簡素化を目指す。

Brian

Brianイーロン・マスクは、AIの進歩が2025年までに最も知的な人間の能力をも上回るという大胆な予測を発表した。

Catherine

CatherineCrypto.comのドバイ部門が完全な運営承認を獲得し、機関投資家へのサービス提供のマイルストーンとなる。UAEのクリプト・フレンドリーな環境はビジネスを引き付け続け、ドバイを世界的なクリプト・ハブとして位置づけている。

Weiliang

Weiliangスイス国立銀行は、潜在的なリスクを理由に公的デジタル通貨のアイデアを拒否し、ホールセールCBDCに集中することを好む。懸念はあるものの、スイス国立銀行は決済技術を前進させている。しかし、スイス国立銀行は今後の課題も認識しており、慎重でありながらも先進的な姿勢を崩していない。

Alex

AlexFriend3はProBit Globalと協力し、F3トークンの有用性を活用した分散型寄付メカニズムと取引コンテストを導入し、コミュニティのエンゲージメントを促進します。Web3テクノロジーにより、Friend3は革新的なマネタイズオプションを備えたコミュニティ創出のパイオニアとなります。

Alex

AlexBitMEXの共同設立者であるベン・デロに対する集団訴訟は、規制を明確にする必要性を強調し、暗号通貨業界の事業者が直面する潜在的な法的リスクを浮き彫りにした。

Weiliang

Weiliangフィリピン証券取引委員会(SEC)によるバイナンスの取引禁止措置は、投資家の間で懸念が高まっており、コンプライアンス上の問題や投資家保護に対するSECのコミットメントが浮き彫りになっている。

Miyuki

Miyuki